هیچ محصولی در سبد خرید نیست.

چرا کرالر گوگل مهم است؟۸ دلیل و راهکار بهینهسازی خزش سایت

کرالر گوگل (Googlebot) یکی از مهمترین ابزارهای موتور جستجوی گوگل است که نقش حیاتی در فرآیند خزیدن وب و ایندکس صفحات سایتها دارد. این کرالر مسئول شناسایی، بررسی و ثبت محتوای صفحات مختلف وبسایتها است تا موتور جستجوی گوگل بتواند این اطلاعات را در نتایج جستجو نمایش دهد. بدون عملکرد درست کرالر گوگل، سایتها نمیتوانند در نتایج جستجو دیده شوند و این امر باعث کاهش رتبه سایت میشود.

در این مقاله، به بررسی نحوه کار کرالر گوگل و اهمیت آن در بهینهسازی سئو سایت خواهیم پرداخت. همچنین، روشهای مختلف بهینهسازی ساختار سایت، سرعت بارگذاری، و استراتژیهای لینکسازی داخلی و خارجی برای تسهیل فرآیند خزیدن و ایندکس صفحات توسط کرالر گوگل بررسی خواهند شد. هدف ما این است که نشان دهیم چگونه میتوان از این ربات قدرتمند برای افزایش بازدید و ارتقای رتبه سایت در موتور جستجو استفاده کرد.

محتوا

پنهان

کرالر یا Crawler چیست و چطور کار میکند؟

تعریف و مفهوم کرالر

کرالر گوگل (Googlebot) یکی از مهمترین رباتها یا خزندههای موتور جستجو است که مسئول جستوجو و جمعآوری اطلاعات از وبسایتها برای ایندکس کردن آنها است. این کرالر با استفاده از الگوریتمهای پیشرفته صفحات مختلف را بررسی کرده، لینکها را دنبال میکند و محتوای آنها را برای ذخیرهسازی در پایگاه داده موتور جستجو جمعآوری میکند. کرالر گوگل به این شکل عمل میکند که ابتدا وبسایتها را شناسایی کرده، سپس صفحات آنها را از طریق لینکهای داخلی و خارجی خزیده و اطلاعات جدید را بهروز رسانی میکند.

برای مثال، اگر یک وبسایت خبری مطالب جدیدی منتشر کند، کرالر گوگل بهطور خودکار به این صفحات سر میزند و آنها را ایندکس میکند. بدون این فرآیند، سایتها نمیتوانند در نتایج جستجو ظاهر شوند و شانس رتبهبندی کاهش مییابد.

نقش کرالر در موتورهای جستجو

کرالر گوگل یکی از ارکان اصلی عملکرد موتور جستجوی گوگل است. بدون کرالرها، گوگل نمیتواند اطلاعات موجود در صفحات وب را شناسایی کرده و ایندکس کند. این کرالرها به طور مداوم صفحات جدید و بهروز را بررسی کرده و آنها را در پایگاه داده گوگل ذخیره میکنند. کرالر گوگل در واقع نقش یک نقشهبردار دیجیتال را ایفا میکند که به موتور جستجو کمک میکند محتوای جدید و مرتبط را شناسایی و در نتایج جستجو نمایش دهد.

نقش کرالر گوگل به قدری حیاتی است که هر تغییر کوچک در نحوه خزیدن سایتها، میتواند به طور مستقیم بر رتبه سایت در نتایج جستجو تأثیر بگذارد. به همین دلیل است که بهینهسازی ساختار سایت و محتوای آن برای کرالرها، یکی از اجزای اصلی سئو است.

تفاوت کرالر با ایندکسینگ و رباتهای دیگر

کرالر گوگل اغلب با دو فرآیند دیگر موتور جستجو اشتباه گرفته میشود: ایندکسینگ و رباتهای دیگر. در حالی که کرالر به جمعآوری اطلاعات از صفحات وب میپردازد، ایندکسینگ به فرآیند ذخیرهسازی و سازماندهی این اطلاعات در پایگاه داده گوگل اشاره دارد. به عبارتی، کرالر وبسایتها را بررسی میکند، اما ایندکسینگ تصمیم میگیرد که چه اطلاعاتی در نتایج جستجو نمایش داده شود.

همچنین، موتور جستجوها از رباتهای دیگری مانند Bingbot برای موتور جستجو بینگ و Yandexbot برای یاندکس استفاده میکنند که وظیفه مشابهی دارند، اما هرکدام از این رباتها تفاوتهایی در نحوه خزیدن، اولویتبندی صفحات و سرعت ایندکس صفحات دارند. برای مثال، کرالر گوگل ممکن است با محتوای جاوااسکریپت تعامل بیشتری داشته باشد، در حالی که دیگر رباتها ممکن است محدودیتهایی در این زمینه داشته باشند. این تفاوتها میتواند تأثیر مستقیمی بر رتبهبندی سایتها در موتور جستجو بگذارد.

برای اطلاعات دقیق و رسمی در مورد نحوه خزیدن و ایندکسینگ صفحات سایتها توسط کرالر گوگل، برای مطالعه بیشتر این مقاله Crawling and Indexing را بخوانید.

انواع کرالرها و وظایف آنها

کرالرهای عمومی (General Crawlers)

کرالرهای عمومی یا Googlebot، معمولاً برای خزیدن در تمام صفحات وبسایتها طراحی شدهاند و از این رو به طور وسیع در اکثر سایتها فعال هستند. کرالر گوگل یکی از این کرالرهای عمومی است که برای خزیدن در سایتها، شناسایی لینکها و جمعآوری اطلاعات به منظور ایندکس صفحات استفاده میشود. این کرالرها به طور خودکار و به صورت دورهای سایتها را بررسی کرده و دادههای جدید را جمعآوری میکنند.

برای مثال، Googlebot بهطور منظم سایتهایی مانند Wikipedia و News sites را بررسی کرده و اطلاعات جدید را برای ایندکس کردن سایت به گوگل ارسال میکند. کرالر گوگل در این حالت، بدون محدودیت و با توجه به اولویتها و نیازهای الگوریتمی، اقدام به خزش تمام صفحات سایت میکند.

کرالرهای تخصصی (Focused Crawlers)

کرالرهای تخصصی یا Focused Crawlers به گونهای طراحی شدهاند که فقط در دستهبندی خاصی از صفحات یا اطلاعات وبسایتها فعالیت کنند. این کرالرها معمولاً بهطور خاص برای جستجو و جمعآوری اطلاعات مرتبط با یک حوزه یا موضوع خاص استفاده میشوند.

برای مثال، کرالرهای گوگل که برای جمعآوری اطلاعات علمی و پژوهشی بهطور ویژه طراحی شدهاند، ممکن است تنها به صفحات دانشگاهی و مقالات تحقیقاتی بپردازند. در این حالت، کرالر گوگل از محدودیتهای خاصی پیروی میکند و فقط به صفحات و لینکهایی که حاوی محتوای علمی یا پژوهشی هستند دسترسی پیدا میکند. این نوع کرالرها معمولاً در موتورهای جستجو و پایگاههای داده علمی کاربرد دارند.

کرالرهای داخلی و سایتهای بزرگ

سایتهای بزرگ و پیچیده مانند فروشگاههای آنلاین یا وبسایتهای خبری معمولاً از کرالرهای داخلی استفاده میکنند. این کرالرها در واقع به سایت کمک میکنند تا ساختار داخلی آن بهطور مؤثر توسط کرالر گوگل و سایر رباتها شناسایی شود. این نوع کرالرها معمولا صفحات داخلی را بررسی کرده و به بهبود Crawl Budget و ایندکس شدن صفحات مهم کمک میکنند.

برای مثال، یک فروشگاه آنلاین که هزاران صفحه محصول دارد، از کرالرهای داخلی برای هدایت کرالر گوگل به سمت محصولات پرفروش و صفحات مهم استفاده میکند تا مطمئن شود که این صفحات بهطور سریع و بهینه ایندکس میشوند.

کرالرهای خزنده محتوا و دادههای ساختیافته

کرالرهای خزنده محتوا و دادههای ساختیافته مسئول جمعآوری اطلاعات مرتبط با دادههای ساختیافته (Structured Data) هستند. این نوع کرالرها قادرند دادههای مربوط به نشانهگذاریهای schema.org، دادههای JSON-LD و RDFa را شناسایی کنند و آنها را برای بهبود نمایش سایتها در نتایج جستجو ذخیره کنند.

به عنوان مثال، اگر یک سایت فروشگاهی از دادههای ساختیافته برای نمایش قیمت محصولات، نقد و بررسیها یا موجودی استفاده کند، کرالر گوگل بهطور ویژه به این دادهها توجه کرده و آنها را برای نمایش در نتایج غنی گوگل ایندکس میکند. این روش باعث میشود که صفحات به طور ویژه در نتایج جستجو برجسته شوند و در کنار اطلاعات معمولی، جزئیات بیشتری از محصول یا خدمات به کاربران نشان داده شود.

انواع کرالرها و وظایف آنها

| نوع کرالر | توضیحات | مثالها |

|---|---|---|

| کرالر عمومی | خزیدن عمومی تمامی صفحات سایتها. | Googlebot (کرالر گوگل) |

| کرالر تخصصی | خزیدن صفحات خاص بر اساس موضوعات خاص | Backlink Crawlers، Content Crawlers |

| کرالر داخلی | مخصوص خزیدن سایتهای بزرگ و پیچیده | کرالرهای استفادهشده در سایتهای تجاری بزرگ |

| کرالر خزنده محتوا | خزیدن دادههای ساختیافته و محتوای خاص | کرالرهای ویدئویی و تصاویر، سایتهای خبری |

اگر میخواهید بیشتر در مورد نحوه عملکرد کرالرها و کاربردهای آنها در سئو بدانید، برای مطالعه بیشتر این مقاله What is a Web Crawler را بخوانید.

نحوه عملکرد کرالر در وب

خزش صفحات و جمعآوری اطلاعات (Crawling)

کرالر گوگل یا Googlebot اولین گام در فرآیند خزیدن وب را با شناسایی صفحات جدید و بروزرسانیهای موجود در وبسایتها انجام میدهد. این کرالر بهطور خودکار به صفحات مختلف سایتها دسترسی پیدا کرده، آنها را بازدید کرده و اطلاعات آنها را جمعآوری میکند. خزش صفحات به این معناست که کرالر با دنبال کردن لینکهای داخلی و خارجی، صفحات جدید سایت را شناسایی و محتوای آنها را برای ایندکس در موتور جستجوی گوگل ارسال میکند.

برای مثال، کرالر گوگل بهطور دورهای سایتهای خبری و فروشگاهی را بررسی کرده و بهمحض انتشار محتوای جدید، آن را برای ایندکس به گوگل ارسال میکند. این فرآیند باعث میشود که اطلاعات جدید سریعتر به نتایج جستجو اضافه شوند و کاربران بتوانند از محتوای تازه استفاده کنند.

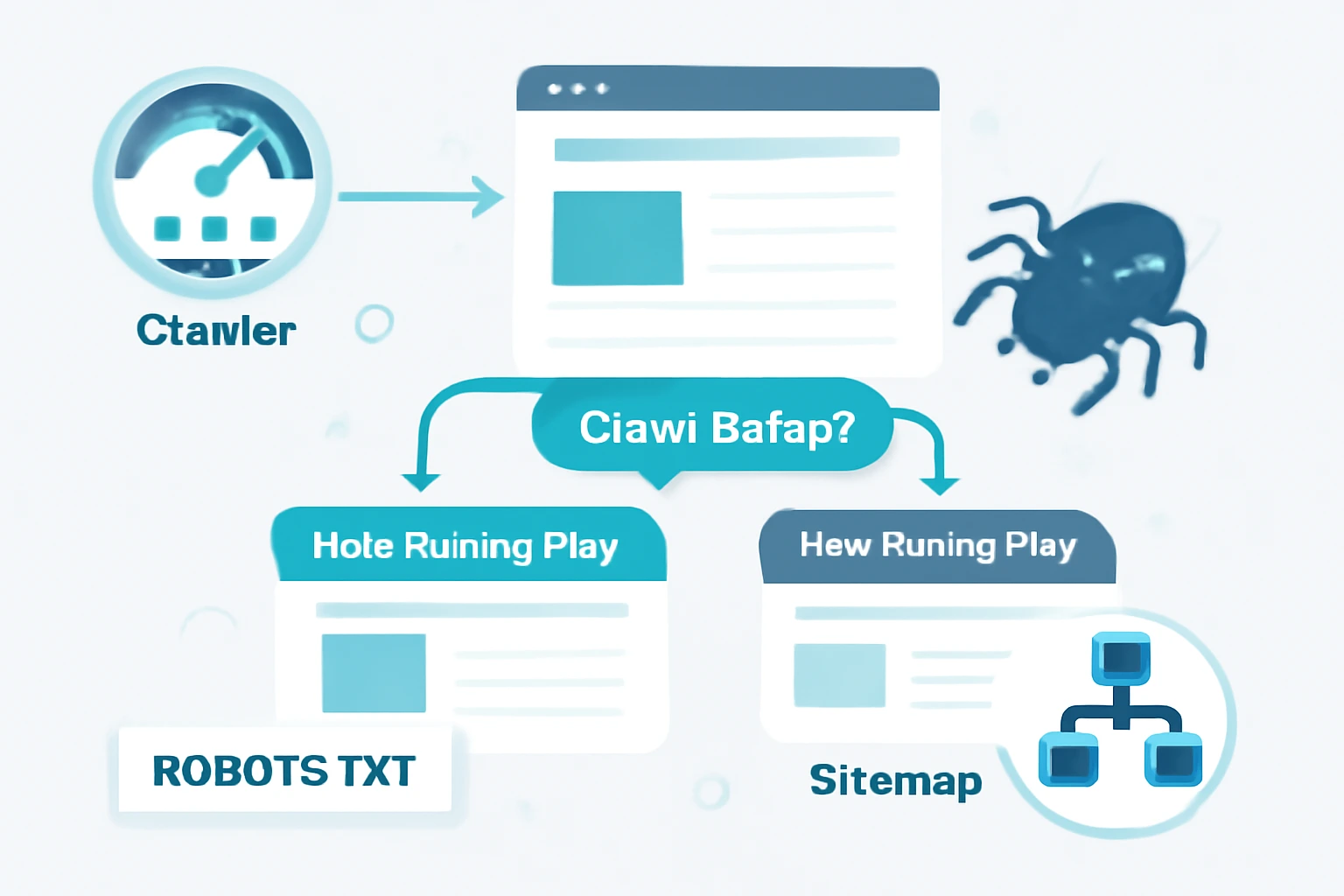

بررسی و پیروی از فایل robots.txt

فایل robots.txt یکی از ابزارهای کلیدی برای مدیریت دسترسی کرالر گوگل به سایت است. این فایل به کرالرها دستور میدهد که کدام صفحات یا بخشهای سایت باید خزیده شوند و کدام بخشها باید نادیده گرفته شوند. به عبارت دیگر، کرالر گوگل طبق دستورات موجود در این فایل رفتار میکند و تنها به صفحاتی که برایش مجاز است دسترسی پیدا میکند.

برای مثال، اگر شما نخواهید که کرالر گوگل به صفحات پرداخت یا اطلاعات حساس دسترسی داشته باشد، میتوانید با استفاده از فایل robots.txt آنها را از دسترس کرالر خارج کنید. این فرآیند میتواند به بهینهسازی Crawl Budget و جلوگیری از خزیدن صفحات غیرضروری کمک کند.

تشخیص لینکها و ساختار سایت

کرالر گوگل بهطور مداوم لینکهای داخلی و خارجی سایت را شناسایی میکند. این کرالر برای دنبال کردن لینکها از یک صفحه به صفحه دیگر استفاده میکند و از طریق این لینکها، محتوای سایت را بررسی میکند. ساختار سایت باید بهگونهای باشد که لینکهای داخلی واضح و هدفمند باشند تا کرالر گوگل بتواند به راحتی صفحات مهم را پیدا کرده و ایندکس کند.

برای مثال، اگر یک وبسایت فروشگاهی لینکهای داخلی مرتبط با دستهبندیهای محصولات و محصولات را به درستی تنظیم کرده باشد، کرالر گوگل میتواند به راحتی صفحات پرفروش و محبوب را شناسایی کند و سریعتر آنها را ایندکس کند.

“برای آشنایی با مراحل طراحی سایت و اهمیت ساختار صفحات برای بهینهسازی خزیدن کرالرها، مقاله [طراحی سایت چیست؟] را مطالعه کنید.”

محدودیتها و سهمیه خزش (Crawl Budget)

Crawl Budget به محدودیتهای موجود در فرآیند خزیدن صفحات توسط کرالر گوگل اشاره دارد. این به این معناست که کرالر نمیتواند همه صفحات سایت را در یک زمان بررسی کند و باید به صورت بهینه از منابع خود استفاده کند. بنابراین، برای سایتهای بزرگ و با صفحات متعدد، مدیریت Crawl Budget ضروری است.

برای مثال، در سایتهای بزرگ مانند فروشگاههای آنلاین، کرالر گوگل میتواند صفحات پرفروش و مهم را سریعتر بررسی کند و صفحات کمارزش یا تکراری را نادیده بگیرد تا منابع بهینه مصرف شوند. به همین دلیل، استفاده از نقشه سایت (Sitemap) و لینکسازی داخلی هدفمند به کرالر کمک میکند تا صفحات ارزشمند به درستی شناسایی شوند.

ارتباط با سرور و مدیریت درخواستها (Request Handling)

کرالر گوگل برای خزیدن سایتها از سرور شما درخواستهایی ارسال میکند تا محتوای صفحات را بارگیری کند. نحوه مدیریت این درخواستها میتواند تأثیر زیادی بر سرعت خزش داشته باشد. در صورتی که سرور شما سرعت بالایی نداشته باشد یا بار زیادی داشته باشد، کرالر گوگل نمیتواند صفحات سایت شما را بهطور مؤثر بررسی کند و ممکن است برخی صفحات ایندکس نشوند.

برای مثال، اگر سایت شما دارای سرور کندی باشد که زمان بارگذاری بالایی دارد، کرالر گوگل ممکن است برخی از صفحات را از دست بدهد و آنها را ایندکس نکند. به همین دلیل، استفاده از CDN (شبکه تحویل محتوا) و بهینهسازی سرعت سرور برای افزایش عملکرد کرالر گوگل بسیار حیاتی است.

برای درک دقیقتر نحوه خزیدن و ایندکس کردن محتوای سایتها توسط کرالر گوگل، برای مطالعه بیشتر این مقاله How Does Google Crawl & Index Content را بخوانید.

تاثیر کرالرها بر سئو و رتبه سایت

اهمیت ساختار سایت و نقشه سایت (Sitemap)

یکی از اصلیترین عواملی که بر نحوه عملکرد کرالر گوگل و سئو سایت تأثیر میگذارد، ساختار سایت و استفاده صحیح از نقشه سایت (Sitemap) است. یک نقشه سایت به کرالر گوگل کمک میکند تا مسیرهای مختلف سایت را شناسایی کرده و صفحاتی که باید ایندکس شوند را شناسایی کند. این نقشه باید بهطور منظم بهروز شود و شامل تمام صفحات مهم و جدید سایت باشد تا کرالرها به راحتی به آنها دسترسی پیدا کنند.

برای مثال، سایتهای فروشگاهی با هزاران محصول و صفحه دستهبندی باید از نقشه سایت XML استفاده کنند تا کرالر گوگل بتواند همه صفحات محصولات، دستهبندیها و صفحات مهم دیگر را سریعتر ایندکس کند. بهینهسازی نقشه سایت و ساختار داخلی باعث میشود کرالر گوگل به بهترین شکل ممکن صفحات را شناسایی کرده و در نتایج جستجو قرار دهد.

سرعت بارگذاری و دسترسی کرالرها

کرالر گوگل به سرعت بارگذاری سایت حساس است، زیرا این خزندهها منابع محدودی دارند و نمیتوانند منتظر بارگذاری صفحات با زمان زیاد بمانند. سرعت بارگذاری پایین سایت میتواند بر روند خزیدن وب تاثیر منفی بگذارد و باعث شود که کرالر گوگل نتواند همه صفحات سایت را بررسی کند. به همین دلیل، سئو خارجی سایت و سئو داخلی سایت از جنبههای مختلفی از جمله سرعت بارگذاری، تحت تأثیر عملکرد کرالرها قرار میگیرد.

برای مثال، یک سایت خبری با محتوای جدید و بهروز، اگر زمان بارگذاری بالایی داشته باشد، کرالر گوگل نمیتواند همه مقالات و اخبار را سریعاً ایندکس کند. بنابراین، بهینهسازی سرعت سایت با استفاده از کش مرورگر، فشردهسازی تصاویر و استفاده از شبکه توزیع محتوا (CDN)، نه تنها تجربه کاربری را بهبود میبخشد، بلکه به کرالر گوگل کمک میکند تا صفحات را سریعتر خزیده و ایندکس کند.

کراولینگ صفحات تکراری و Thin Content

یکی از چالشهای رایج در خزش سایتها، کراولینگ صفحات تکراری و محتوای نازک (Thin Content) است. کرالر گوگل برای شناسایی و ایندکس محتوای با کیفیت بهینهسازی میشود، بنابراین صفحاتی که دارای محتوای تکراری یا کمارزش هستند، به راحتی ایندکس نمیشوند یا به رتبه پایینتری در نتایج جستجو دست پیدا میکنند.

برای جلوگیری از مشکلات Crawl Budget و ایندکس صفحات تکراری، باید از تگهای Canonical برای معرفی صفحات اصلی و جلوگیری از خزش صفحات مشابه استفاده کرد. برای مثال، در یک سایت فروشگاهی که محصولات مشابه دارند، استفاده از تگ canonical باعث میشود که کرالر گوگل تنها صفحه اصلی محصول را ایندکس کند و از ایندکس صفحات تکراری جلوگیری شود.

تاثیر لینکهای داخلی و خارجی بر خزش و ایندکسینگ

لینکهای داخلی و لینکهای خارجی تأثیر زیادی بر فرآیند خزش و ایندکسینگ دارند. کرالر گوگل با دنبال کردن لینکهای داخلی، مسیرهای جدیدی را برای خزیدن و شناسایی صفحات پیدا میکند. بنابراین، لینکسازی داخلی بهطور هدفمند میتواند به بهبود ایندکس صفحات و افزایش سرعت ایندکس صفحات جدید کمک کند.

برای مثال، در یک سایت آموزشی، لینکسازی داخلی بین مقالات مرتبط باعث میشود که کرالر گوگل به راحتی صفحات مهم و محتوای با کیفیت را شناسایی کند. علاوه بر این، لینکهای خارجی از سایتهای معتبر و مرتبط میتوانند اعتبار صفحه را افزایش دهند و تاثیر مثبتی بر رتبه سایت در نتایج جستجو داشته باشند. در این راستا، کرالر گوگل با دنبال کردن این لینکها، اعتبار سایت را افزایش داده و صفحات با کیفیت را سریعتر ایندکس میکند.

“برای آشنایی بیشتر با نحوه تأثیر سئو محلی بر رتبهبندی سایت و نحوه بهینهسازی صفحات محلی، مقاله [سئو محلی چیست؟] را مطالعه کنید.”

اگر به دنبال یادگیری در مورد نحوه خزیدن، ایندکس کردن و رتبهبندی محتوا توسط موتورهای جستجو هستید، برای مطالعه بیشتر این مقاله How Search Engines Crawl, Index, and Rank Content را بخوانید.

مشکلات رایج کرالرها و راهحلها

صفحاتی که کرالر نمیتواند بخزد

کرالر گوگل ممکن است نتواند برخی صفحات سایت را بخزد یا ایندکس کند. این مشکل معمولاً به دلیل تنظیمات نادرست در فایل robots.txt یا تگهای Noindex رخ میدهد. صفحات مشخصی که نمیخواهید کرالر به آنها دسترسی داشته باشد، باید در این فایل مسدود شوند، در غیر این صورت ممکن است باعث شود کرالر گوگل بهطور اشتباهی به این صفحات سر بزند و وقت و منابع سایت هدر رود.

برای مثال، یک سایت تجارت الکترونیک که دارای صفحات پرداخت است، میتواند با استفاده از تگ Noindex یا تنظیمات مناسب در robots.txt از خزیدن این صفحات توسط کرالر گوگل جلوگیری کند. همچنین، اطمینان از اینکه صفحات مهم ایندکس میشوند، میتواند به بهبود سرعت ایندکس صفحات و افزایش رتبه سایت در نتایج جستجو کمک کند.

خطاهای سرور و صفحات ۴۰۴

خطاهای سرور و صفحات 404 یکی از رایجترین مشکلاتی هستند که کرالر گوگل ممکن است با آنها مواجه شود. زمانی که کرالر به یک صفحه با خطای سرور (مثلاً 500) یا صفحه 404 برخورد کند، نمیتواند آن صفحه را ایندکس کند و ممکن است در طولانیمدت بر Crawl Budget سایت تاثیر منفی بگذارد.

برای رفع این مشکل، باید بهطور منظم گزارشهای Google Search Console را بررسی کرده و خطاهای سرور را شناسایی کرد. برای مثال، صفحات 404 باید با یک صفحه مناسب هدایت شوند یا از طریق ردایرکت 301 به صفحات صحیح منتقل شوند. این کار به کرالر گوگل کمک میکند تا از خزش صفحات اشتباه جلوگیری کند و منابع خود را بر روی صفحات مهم تمرکز کند.

محتوای داینامیک و AJAX برای کرالرها

کرالر گوگل قادر به خواندن و ایندکس کردن محتوای داینامیک و AJAX بهطور مستقیم نیست. محتوای ساخته شده با JavaScript یا AJAX ممکن است برای کرالرها قابل دسترسی نباشد و باعث شود که این بخشها ایندکس نشوند. برای رفع این مشکل، استفاده از Server-Side Rendering یا Pre-rendering بسیار مفید است.

برای مثال، یک سایت فروشگاهی که از AJAX برای بارگذاری محصولات استفاده میکند، باید از تکنیکهای Server-Side Rendering استفاده کند تا محتوای موجود در این صفحات برای کرالر گوگل قابل شناسایی باشد. این روش باعث میشود که محتوای مهم و ارزشمند بدون مشکل ایندکس شود و در نتایج جستجو نمایش داده شود.

جلوگیری از کراولینگ اسپم و لینکهای غیرمجاز

کرالر گوگل ممکن است به صفحات اسپم یا لینکهای غیرمجاز دسترسی پیدا کند، که میتواند باعث کاهش کیفیت سایت و حتی جریمه شدن آن شود. جلوگیری از کراولینگ اسپم و لینکهای غیرمجاز با استفاده از ابزارهایی مانند robots.txt و Disavow Links انجام میشود.

برای مثال، اگر یک سایت بهطور اشتباهی لینکهایی به سایتهای اسپم یا بیکیفیت دارد، استفاده از ابزار Disavow در Google Search Console به کرالر گوگل کمک میکند تا این لینکها را نادیده بگیرد. این عمل میتواند از افت رتبه سایت جلوگیری کند و اجازه دهد کرالر گوگل به صفحات اصلی و با کیفیت بیشتر توجه کند.

ابزارها و تکنیکهای مانیتورینگ کرالر

Google Search Console و گزارش Coverage

یکی از بهترین ابزارها برای مانیتورینگ عملکرد کرالر گوگل، Google Search Console است. این ابزار به شما امکان میدهد گزارشهایی دقیق از وضعیت ایندکس صفحات سایت خود دریافت کنید. گزارش Coverage در Google Search Console بهطور خاص نشان میدهد که کدام صفحات توسط کرالر گوگل ایندکس شدهاند و کدام صفحات مشکلاتی دارند که مانع از ایندکس شدن آنها شده است.

برای مثال، اگر کرالر گوگل با خطاهای سرور یا مشکلاتی در دسترسی به صفحات مواجه شود، این گزارش به شما اطلاع میدهد تا سریعاً اقدام به رفع آنها کنید. با بررسی دقیق گزارشها، میتوانید از مشکلات ایندکس و Crawl Budget جلوگیری کنید و سایت خود را به بهترین شکل بهینه کنید.

Screaming Frog و بررسی کامل سایت

Screaming Frog یکی از ابزارهای محبوب برای شبیهسازی رفتار کرالر گوگل است. این ابزار به شما این امکان را میدهد که به طور کامل سایت خود را بررسی کرده و مشکلاتی مانند لینکهای شکسته، صفحات تکراری و Crawl Budget ضعیف را شناسایی کنید. Screaming Frog تمامی صفحات سایت را خزیده و اطلاعاتی نظیر وضعیت ایندکس، متا تگها، وضعیت 301 و 404 را جمعآوری میکند.

برای مثال، با استفاده از Screaming Frog میتوانید بررسی کنید که آیا صفحات کمارزش یا صفحات با محتوای Thin Content توسط کرالر گوگل خزیده شدهاند یا خیر. این ابزار به شما کمک میکند تا از مصرف بیرویه Crawl Budget جلوگیری کرده و به کرالر گوگل اجازه دهید که تنها صفحات مهم سایت را بررسی کند.

Ahrefs و SEMrush برای مشاهده خزیدن سایت

Ahrefs و SEMrush دو ابزار قدرتمند هستند که برای مشاهده رفتار کرالر گوگل و تحلیل لینکهای سایت استفاده میشوند. این ابزارها به شما این امکان را میدهند که خزش سایت را مشاهده کرده و مشکلاتی مانند لینکهای خراب، محتوای تکراری، و مشکلات ایندکس صفحات را شناسایی کنید.

برای مثال، در Ahrefs میتوانید گزارشهایی از وضعیت لینکهای داخلی و خارجی سایت دریافت کنید و ببینید که کدام صفحات بیشتر مورد توجه کرالر گوگل قرار گرفتهاند. این ابزار به شما این امکان را میدهد که استراتژیهای لینکسازی را بر اساس رفتار کرالر گوگل تنظیم کنید و مطمئن شوید که لینکهای داخلی بهطور هدفمند هدایت میشوند.

Log File Analysis برای رفتار کرالرها

تحلیل فایلهای لاگ (Log File Analysis) یکی از دقیقترین روشها برای مشاهده رفتار کرالر گوگل است. با استفاده از این روش، میتوانید دقیقاً ببینید که کدام صفحات توسط کرالرها بازدید شدهاند و در چه زمانی این خزشها انجام شدهاند. این تحلیل به شما کمک میکند تا مشکلاتی مانند صفحات بیارزش که توسط کرالر گوگل بررسی شدهاند یا صفحاتی که زمان زیادی برای خزیدن نیاز دارند، شناسایی کنید.

برای مثال، با تحلیل فایلهای لاگ، میتوانید ببینید که کرالر گوگل به صفحات مهم سایت شما توجه کرده است یا نه، و آیا مشکلاتی مانند خطاهای 404 یا صفحات غیرایندکس شده وجود دارند که نیاز به اصلاح دارند. این تکنیک یکی از روشهای مفید برای مدیریت Crawl Budget است و به شما کمک میکند تا عملکرد سایت خود را بهبود بخشید.

“برای یادگیری تکنیکهای لینکسازی حرفهای و نحوه استفاده از ابزارهای سئو برای تحلیل لینکها، مقاله [لینکسازی طلایی] را مطالعه کنید.”

ابزارهای مانیتورینگ کرالر گوگل و تحلیل عملکرد سایت

| ابزار | توضیحات | کاربرد در مانیتورینگ کرالرها |

|---|---|---|

| Google Search Console | ابزار رسمی گوگل برای بررسی ایندکس و عملکرد صفحات سایت | مشاهده وضعیت ایندکس و گزارش خطاهای خزیدن |

| Screaming Frog | ابزار برای شبیهسازی رفتار کرالر گوگل | بررسی وضعیت لینکها، صفحات 404، و محتوای تکراری |

| Ahrefs | ابزار SEO معروف برای بررسی بک لینکها و خزیدن سایت | مشاهده وضعیت خزیدن سایت و لینکها |

| SEMrush | ابزار تجزیه و تحلیل سئو برای مشاهده رتبهبندی و مشکلات خزیدن | مشاهده وضعیت ایندکس و گزارشهای خزیدن |

برای یادگیری نحوه استفاده از ابزار Screaming Frog برای بررسی عملکرد کرالر گوگل و سئو تکنیکال، برای مطالعه بیشتر این مقاله A Complete Guide to Technical SEO را بخوانید.

بهترین شیوهها برای بهینهسازی خزیدن سایت

بهینهسازی ساختار URL و سلسلهمراتب سایت

یکی از مهمترین عوامل برای بهینهسازی خزیدن سایت توسط کرالر گوگل، ساختار URL بهینه و سلسلهمراتب سایت است. برای اینکه کرالر گوگل بتواند بهطور مؤثر سایت شما را خزیده و ایندکس کند، باید از ساختار URL ساده و منطقی استفاده کنید. این کار کمک میکند تا کرالر به راحتی صفحات سایت را شناسایی کرده و مسیرهای آنها را دنبال کند.

برای مثال، یک فروشگاه آنلاین که از ساختار URL منطقی مانند example.com/products/category استفاده میکند، به کرالر گوگل کمک میکند تا تمام صفحات محصول و دستهبندیها را بهراحتی پیدا کرده و ایندکس کند. همچنین، بهتر است از URLهای کوتاه و بدون پارامترهای پیچیده استفاده کنید تا کرالر گوگل بتواند به سرعت به صفحات سایت دسترسی پیدا کند.

بهبود سرعت بارگذاری و تجربه کاربری

سرعت بارگذاری یکی از عواملی است که بر عملکرد کرالر گوگل تأثیر زیادی دارد. سایتهایی که سرعت بارگذاری بالایی دارند، به کرالر گوگل این امکان را میدهند که سریعتر به صفحات دسترسی پیدا کرده و آنها را ایندکس کند. علاوه بر این، تجربه کاربری نیز برای گوگل اهمیت دارد، زیرا کرالر گوگل به سایتهایی که سرعت بارگذاری بالایی دارند و تجربه کاربری مناسبی ارائه میدهند، اولویت میدهد.

برای مثال، فشردهسازی تصاویر، استفاده از کش مرورگر و بهینهسازی کدهای CSS و JavaScript میتواند به سرعت بارگذاری سایت کمک کرده و کرالر گوگل را قادر سازد که سریعتر صفحات سایت شما را خزیده و ایندکس کند.

استفاده از فایل robots.txt و متا تگها

فایل robots.txt یکی از ابزارهای مهم برای مدیریت دسترسی کرالر گوگل به صفحات سایت است. شما میتوانید با استفاده از این فایل تعیین کنید که کدام صفحات باید توسط کرالرها خزیده شوند و کدام صفحات باید نادیده گرفته شوند. به علاوه، متا تگها مانند Noindex نیز برای جلوگیری از ایندکس شدن صفحات خاص بسیار مفید هستند.

برای مثال، اگر میخواهید صفحات ورود یا پرداخت را از دسترسی کرالر گوگل خارج کنید، میتوانید از تگ Noindex در هدر صفحه استفاده کنید یا این صفحات را در robots.txt مسدود کنید. این اقدامات کمک میکنند تا Crawl Budget بهطور مؤثر مدیریت شود و کرالر به صفحات مهم سایت تمرکز کند.

لینکسازی داخلی هدفمند برای هدایت کرالر

لینکسازی داخلی یکی از تکنیکهای قدرتمند برای هدایت کرالر گوگل به صفحات مهم سایت است. با ایجاد لینکهای داخلی هدفمند، میتوانید مسیرهای مختلف سایت را به کرالرها نشان دهید و مطمئن شوید که صفحات با ارزش سریعتر ایندکس میشوند. این کار همچنین باعث توزیع قدرت صفحه (link juice) در سراسر سایت میشود و رتبهبندی صفحات کلیدی را بهبود میبخشد.

برای مثال، اگر شما یک مقاله جامع منتشر کردهاید، میتوانید در مقالات دیگر لینکهای داخلی به این مقاله اضافه کنید تا کرالر گوگل بتواند به راحتی آن را شناسایی و ایندکس کند. این لینکهای داخلی همچنین به کاربران کمک میکنند تا به راحتی به محتوای مرتبط دسترسی پیدا کنند و تجربه کاربری بهتری داشته باشند.

“برای اطلاعات بیشتر در مورد تعرفههای سئو و نحوه انتخاب پکیج مناسب برای لینکسازی، مقاله [تعرفه سئو در سال 1404] را بخوانید.”

محتوای ارزشمند و قابل ایندکس برای کرالرها

برای اینکه کرالر گوگل بتواند بهطور مؤثر سایت شما را ایندکس کند، باید محتوای ارزشمند و قابل ایندکس را بهطور منظم منتشر کنید. محتوای غنی از اطلاعات، استفاده از دادههای ساختیافته (structured data) و بهینهسازی محتوای برای کرالرها باعث میشود که صفحات شما سریعتر ایندکس شوند و در نتایج جستجو رتبه بهتری کسب کنند.

برای مثال، اگر شما یک سایت خبری دارید، کرالر گوگل باید بتواند به راحتی مطالب جدید را شناسایی و ایندکس کند. استفاده از دادههای ساختیافته برای نمایش اخبار در قالب نتایج غنی (Rich Snippets) به کرالر گوگل کمک میکند تا محتوای شما را بهطور مؤثرتر پردازش کند و آن را در نتایج جستجو بهتر نمایش دهد.

استراتژیهای موفق برای بهینهسازی Crawl Budget

| استراتژی | توضیحات | مزایا |

|---|---|---|

| مدیریت صفحات تکراری | استفاده از تگهای canonical برای جلوگیری از ایندکس صفحات تکراری | کاهش مصرف Crawl Budget و جلوگیری از تکراری ایندکس شدن |

| محتوای Thin Content | جلوگیری از ایندکس صفحات با محتوای کمارزش | بهینهسازی Crawl Budget برای صفحات با محتوای با کیفیت |

| فایل robots.txt بهینه | مسدود کردن صفحات غیرضروری با robots.txt | جلوگیری از خزیدن صفحات غیرمجاز و کاهش بار روی سرور |

| نقشه سایت XML بهروز | استفاده از نقشه سایت برای هدایت کرالر به صفحات جدید | سریعتر ایندکس شدن صفحات جدید و اولویتبندی آنها |

نکات پیشرفته و استراتژی کرالر برای سایتهای بزرگ

مدیریت کراول بودجه سایتهای بزرگ و فروشگاهی

مدیریت Crawl Budget یکی از مسائل حیاتی برای سایتهای بزرگ و فروشگاهی است. در این سایتها که تعداد صفحات آنها ممکن است به هزاران برسد، کرالر گوگل باید بهطور مؤثر منابع خود را مصرف کرده و از خزیدن بیرویه صفحات بیارزش جلوگیری کند. برای مدیریت بهتر Crawl Budget، سایتها باید ساختار URL بهینه، لینکسازی داخلی هدفمند و محتوای باکیفیت ارائه دهند.

برای مثال، یک سایت فروشگاهی با هزاران محصول باید صفحات پرفروش و مهم را در اولویت قرار دهد و از خزیدن صفحات کمارزش یا مشابه جلوگیری کند. این کار از طریق استفاده از نقشه سایت (Sitemap) و فایل robots.txt برای مسدود کردن صفحات تکراری یا کمارزش انجام میشود. این استراتژیها کمک میکنند تا کرالر گوگل بتواند صفحات ارزشمند را سریعتر ایندکس کند و Crawl Budget بهینهتری مصرف شود.

ایندکسینگ محتوای چندزبانه و بینالمللی

در سایتهای چندزبانه و بینالمللی، کرالر گوگل باید بتواند بهطور مؤثر محتوای مرتبط با هر زبان و منطقه را ایندکس کند. برای این کار، استفاده از hreflang tags ضروری است. این تگها به کرالر گوگل کمک میکنند تا محتوای صفحات مختلف سایت را که برای زبانها یا کشورهای مختلف طراحی شدهاند، شناسایی کند.

برای مثال، یک سایت جهانی که در چند زبان مختلف فعال است، باید بهطور دقیق از تگهای hreflang استفاده کند تا مطمئن شود کرالر گوگل صفحات صحیح را برای هر زبان ایندکس کرده و نتایج مرتبط را برای کاربران نمایش دهد. بدون استفاده صحیح از این تگها، کرالر گوگل ممکن است صفحات اشتباهی را ایندکس کرده و باعث کاهش کیفیت نتایج جستجو شود.

مانیتورینگ تغییرات و بروزرسانی محتوا

برای سایتهای بزرگ که بهطور مداوم محتوا را بهروز میکنند، مانیتورینگ تغییرات و بروزرسانیها برای اطمینان از خزیدن و ایندکس سریع توسط کرالر گوگل ضروری است. تغییرات در محتوا باید بهطور منظم مورد بررسی قرار گیرند تا اطمینان حاصل شود که صفحات جدید و بروزرسانیها بهدرستی ایندکس میشوند.

برای مثال، اگر یک سایت خبری محتوای جدید منتشر میکند، باید اطمینان حاصل کند که کرالر گوگل بهسرعت این تغییرات را شناسایی کرده و محتوای جدید را ایندکس کند. استفاده از Google Search Console برای مشاهده وضعیت ایندکس صفحات و تنظیم Crawl Budget میتواند به شما کمک کند تا اطمینان حاصل کنید که تغییرات بهدرستی توسط کرالر گوگل خزیده و ایندکس میشوند.

تعامل با رباتها و خزندههای شخص ثالث

کرالر گوگل تنها ربات خزنده موجود نیست. در سایتهای بزرگ، ممکن است رباتهای دیگری مانند Bingbot یا Yandexbot نیز حضور داشته باشند. تعامل با این رباتها و خزندههای شخص ثالث میتواند تأثیر زیادی بر عملکرد کرالر گوگل داشته باشد.

برای مثال، کرالر گوگل ممکن است به محتوای ایندکس شده توسط رباتهای دیگر توجه کرده و آنها را در نتایج جستجو بهطور موازی با نتایج خود نمایش دهد. برای جلوگیری از مشکلات مربوط به Crawl Budget و افزایش سرعت خزیدن، باید اطمینان حاصل کرد که سایت شما از لحاظ robots.txt و تگهای Noindex به درستی تنظیم شده است تا هر ربات تنها به بخشهای مجاز دسترسی داشته باشد.

خلاصه اهمیت کرالرها و نقش آنها در رتبهبندی

کرالر گوگل یکی از اجزای اساسی فرآیند سئو و رتبهبندی سایتها در نتایج جستجو است. بدون این رباتها، موتورهای جستجو نمیتوانند صفحات سایت شما را شناسایی کرده و در نتایج جستجو نمایش دهند. کرالرها با خزیدن صفحات و جمعآوری اطلاعات، به ایندکس کردن صفحات کمک میکنند و در نهایت رتبه سایت شما را در نتایج جستجو تحت تاثیر قرار میدهند. بنابراین، بهینهسازی ساختار سایت و Crawl Budget میتواند تأثیر زیادی در نحوه برخورد کرالر گوگل با سایت شما و ایندکس صفحات مهم داشته باشد.

به طور خلاصه، اگر میخواهید سایت شما در نتایج جستجو رتبه بالاتری داشته باشد، باید مطمئن شوید که کرالر گوگل میتواند بهراحتی و بهطور کامل سایت شما را خزیده و ایندکس کند.

توصیههای عملی برای سایتهای کوچک و بزرگ

برای سایتهای کوچک و بزرگ، مدیریت درست Crawl Budget و بهینهسازی فرآیند خزیدن صفحات توسط کرالر گوگل بسیار مهم است. برای سایتهای کوچک، اطمینان حاصل کنید که ساختار URL ساده و منطقی است و از نقشه سایت (Sitemap) بهطور مؤثر استفاده میکنید تا کرالر گوگل بتواند صفحات شما را سریعتر شناسایی کند. همچنین، مطمئن شوید که فایل robots.txt بهدرستی تنظیم شده باشد و صفحات غیرمجاز برای کرالرها مسدود شوند.

برای سایتهای بزرگ و فروشگاهی، استفاده از تکنیکهای لینکسازی داخلی و مدیریت Crawl Budget ضروری است. همچنین، با بررسی دورهای گزارشهای Google Search Console میتوانید وضعیت ایندکس صفحات را رصد کرده و مشکلات را برطرف کنید. برای سایتهای بزرگ، بهینهسازی سرعت بارگذاری و کاهش زمان تأخیر در خزیدن صفحات نیز اهمیت ویژهای دارد.

مسیر بعدی برای بهینهسازی خزیدن سایت

برای بهینهسازی خزیدن سایت و اطمینان از ایندکس سریع و مؤثر صفحات توسط کرالر گوگل، باید از تکنیکها و ابزارهای مختلف استفاده کنید. اولویتبندی صفحات مهم، استفاده از Server-Side Rendering برای محتوای داینامیک، و اطمینان از اینکه ساختار سایت بهطور منظم بهروز میشود، از جمله اقداماتی هستند که باید در نظر داشته باشید.

برای مسیر بعدی، پیشنهاد میشود که به طور منظم گزارشهای Google Search Console را بررسی کنید تا از وضعیت خزیدن و ایندکس صفحات سایت مطلع شوید. همچنین، با بهکارگیری ابزارهایی مانند Screaming Frog و Ahrefs، میتوانید مشکلات و فرصتهای موجود در فرآیند خزیدن سایت را شناسایی کرده و بهبود دهید. علاوه بر این، استفاده از دادههای ساختیافته (Structured Data) و بهینهسازی محتوای سایت برای کرالر گوگل میتواند به شفافیت فرآیند خزیدن و ایندکسینگ کمک کند.

“برای درک بهتر چگونگی تولید محتوای ارزشمند که همراستا با استراتژی لینکسازی باشد، مقاله [سئو محتوا چیست؟] را مطالعه کنید.”

ادامه یادگیری و منابع مرتبط

مقالات تخصصی درباره کرالرها و خزیدن سایت

برای بهبود دانش شما در زمینه کرالر گوگل و نحوه خزیدن سایتها، مطالعه مقالات تخصصی و منابع معتبر از اهمیت بالایی برخوردار است. این مقالات به شما کمک میکنند تا با مفاهیم پیچیدهای مانند Crawl Budget، robots.txt، و Crawl Optimization آشنا شوید و بدانید چگونه میتوانید فرآیند خزیدن سایت خود را بهبود دهید.

برای مثال، مقالات منتشر شده در سایتهایی مانند Moz و Search Engine Journal میتوانند راهنماییهای عالی در مورد نحوه عملکرد کرالر گوگل و استراتژیهای بهینهسازی خزیدن سایت ارائه دهند. مطالعه این مقالات به شما این امکان را میدهد که از بهترین شیوهها برای بهینهسازی خزیدن و ایندکسینگ سایت خود استفاده کنید.

دورههای آموزش سئو تکنیکال و Crawler

برای کسانی که به دنبال یادگیری عمیقتر در زمینه سئو تکنیکال و نحوه بهینهسازی خزیدن سایتها هستند، دورههای آموزشی آنلاین و کارگاههای تخصصی میتوانند مفید باشند. این دورهها معمولاً شامل موضوعات متنوعی از جمله مدیریت Crawl Budget، استفاده از Google Search Console، و بهینهسازی کرالر گوگل هستند.

به عنوان مثال، دورههای آموزشی از Udemy و Coursera میتوانند به شما در درک مفاهیم پیشرفته سئو و نحوه استفاده بهینه از کرالر گوگل برای خزیدن و ایندکس سایت کمک کنند. این دورهها برای افرادی که میخواهند در زمینه سئو تکنیکال مهارتهای خود را بهبود بخشند بسیار مفید هستند.

ابزارهای پیشرفته مانیتورینگ کرالرها و تحلیل سایت

برای نظارت دقیقتر بر عملکرد کرالر گوگل و بهینهسازی خزیدن سایت، استفاده از ابزارهای پیشرفته مانند Screaming Frog، Ahrefs، و SEMrush ضروری است. این ابزارها به شما این امکان را میدهند که بهطور دقیق رفتار کرالر گوگل را رصد کرده و مشکلات ایندکسینگ یا خزیدن را شناسایی کنید.

برای مثال، Screaming Frog به شما این امکان را میدهد که تمام صفحات سایت را خزیده و بررسی کنید که آیا صفحات کمارزش یا تکراری به درستی ایندکس شدهاند یا خیر. همچنین، Google Search Console بهطور مستقیم گزارشهایی از وضعیت ایندکس و خزیدن سایت ارائه میدهد و به شما کمک میکند تا مشکلات مربوط به Crawl Budget را بهراحتی شناسایی و برطرف کنید.

سوالات متداول درباره کرالرها و خزیدن سایت

کرالرها هر روز چه صفحاتی را بررسی میکنند؟

کرالر گوگل هر روز سایتها را بررسی میکند، اما میزان و زمان بررسی بستگی به Crawl Budget و اهمیت صفحات دارد. صفحات با اولویت بالا مانند صفحه اصلی یا مقالات جدیدتر بهطور مکرر بررسی میشوند، در حالی که صفحات کماهمیت یا صفحات تکراری ممکن است کمتر مورد بررسی قرار گیرند. علاوه بر این، کرالر گوگل همچنین به تغییرات محتوا توجه دارد و به محض بهروز شدن صفحات، ممکن است آنها را دوباره بررسی کند.

برای مثال، اگر شما یک سایت خبری داشته باشید که هر روز محتوای جدیدی منتشر میکند، کرالر گوگل ممکن است هر روز به آن سایت سر بزند تا اخبار جدید را ایندکس کند. از طرف دیگر، سایتهایی که تغییرات زیادی ندارند یا محتوای تکراری دارند، ممکن است نیاز به خزیدن کمتری داشته باشند.

آیا کرالرها میتوانند همه صفحات سایت را ایندکس کنند؟

در حالی که کرالر گوگل ممکن است تمام صفحات سایت را بررسی کند، اما این به معنای ایندکس شدن همه آنها نیست. اگر صفحات سایت شما محتوای Thin Content (محتوای کمارزش) داشته باشد یا تگ Noindex بر روی آنها قرار داده شده باشد، این صفحات توسط کرالر گوگل بررسی خواهند شد، اما ایندکس نخواهند شد. همچنین، فایل robots.txt میتواند به کرالرها دستور دهد که برخی صفحات را نادیده بگیرند.

برای مثال، در یک سایت فروشگاهی که هزاران محصول دارد، ممکن است برخی صفحات با محتوای کمارزش یا صفحات «آموزش استفاده از محصول» ایندکس نشوند زیرا برای سئو سایت اهمیت کمتری دارند. این کار به Crawl Budget کمک میکند و منابع کرالر گوگل صرف بررسی صفحات مهمتر میشود.

تفاوت بین کرالر گوگل و بینگ چیست؟

کرالر گوگل (Googlebot) و Bingbot هر دو از رباتهای خزندهای هستند که برای بررسی و ایندکس صفحات سایتها استفاده میشوند، اما تفاوتهایی در نحوه عملکرد و الگوریتمهای آنها وجود دارد. کرالر گوگل به دلیل استفاده از الگوریتمهای پیچیدهتر و بهروزرسانیهای مستمر، میتواند صفحات را سریعتر ایندکس کرده و اطلاعات دقیقتری را بهدست آورد. در مقابل، Bingbot ممکن است روند خزیدن و ایندکسینگ آهستهتر باشد و صفحات خاصی را که کرالر گوگل بررسی کرده، نادیده بگیرد.

برای مثال، ممکن است کرالر گوگل به محتوای داینامیک ساختهشده با JavaScript توجه بیشتری نشان دهد، در حالی که Bingbot قادر به بررسی این نوع محتوا نباشد. بنابراین، برای بهینهسازی برای هر دو موتور جستجو، باید از تکنیکهایی استفاده کرد که به هر دو ربات دسترسی آسان به صفحات سایت را فراهم کند.

کرالرها چطور با محتوای جاوااسکریپت تعامل دارند؟

کرالر گوگل به خوبی با محتوای جاوااسکریپت تعامل دارد، اما ممکن است در برخی موارد به طور کامل قادر به پردازش و ایندکس کردن محتوای داینامیک نباشد. برای اطمینان از اینکه کرالر گوگل میتواند محتوای جاوااسکریپت را بهطور مؤثر بررسی کند، استفاده از Server-Side Rendering یا Pre-rendering توصیه میشود. این تکنیکها به کرالر گوگل این امکان را میدهند که محتوای جاوااسکریپت را به صورت کامل دریافت و ایندکس کند.

برای مثال، اگر یک سایت فروشگاهی از AJAX برای بارگذاری محصولات استفاده کند، ممکن است کرالر گوگل نتواند این محصولات را ایندکس کند مگر اینکه از Server-Side Rendering یا Pre-rendering استفاده کند. این روشها به کرالر گوگل کمک میکنند تا محتوای داینامیک سایت را به راحتی ایندکس کند و صفحات محصولات جدید را در نتایج جستجو نمایش دهد.

در نهایت این نکته را باید در نظر بگیریم!

بهینهسازی خزیدن سایت و ایندکسینگ توسط کرالر گوگل یکی از مهمترین عوامل موفقیت در سئو است؛ چه در بهینهسازی ساختار سایت برای هدایت بهتر کرالرها و چه در استفاده از تکنیکهای صحیح برای ایندکس صفحات مهم توسط گوگل. اگر استراتژی درستی برای Crawl Budget و بهینهسازی خزیدن سایت نداشته باشید، تمام زحمات تولید محتوا و بهینهسازی فنی ممکن است نتیجه دلخواه را به همراه نداشته باشد.

اگر میخواهید سایت شما سریعتر ایندکس شده و رتبهتان در گوگل بهبود یابد، وقت آن است که استراتژی خزیدن و ایندکسینگ اصولی داشته باشید.

برای دریافت مشاوره تخصصی و بهینهسازی خزیدن سایت، همین امروز با تیم استارتاپ نمو تماس بگیرید.

"کرالر گوگل برای خزیدن و ایندکس کردن صفحات سایتها حیاتی است. با بهینهسازی خزیدن، سایتها میتوانند شانس بهتری برای رتبهبندی در نتایج جستجو داشته باشند."