هیچ محصولی در سبد خرید نیست.

robots.txt چیست؟ راهنمای حرفهای و کامل 1404

«هر کسی را بهر کاری ساختند.» این ضربالمثل ساده را شاید بارها شنیده باشید. دقیقاً همین منطق در دنیای وب هم وجود دارد؛ همه صفحات یک سایت برای یک هدف ساخته نشدهاند و قرار نیست همه آنها در نتایج گوگل نمایش داده شوند. اینجاست که پرسش اصلی مطرح میشود: robots.txt چیست و چرا باید برای مدیریت سایت جدی گرفته شود؟

اگر بخواهیم سریع توضیح بدهیم، robots.txt فایلی متنی است که به موتورهای جستجو اعلام میکند کدام بخشهای سایت را بررسی کنند و کدام بخشها را نادیده بگیرند. همین تعریف ساده، اساس کار این فایل را مشخص میکند.

اهمیت موضوع زمانی روشن میشود که بدانیم ایندکس شدن صفحات مدیریتی، فایلهای تکراری یا بخشهای آزمایشی هیچ کمکی به سئو نمیکند و حتی میتواند بودجه خزش موتورهای جستجو را هدر بدهد. در چنین شرایطی، robots.txt مانند یک راهنما عمل کرده و مسیر بهینه را به خزندهها نشان میدهد.

در ادامه این مقاله بهطور کامل بررسی میکنیم که robots.txt چه نقشی در سئو ایفا میکند، ساختار آن چیست، در چه شرایطی باید از آن استفاده کرد و چه خطاهایی ممکن است به ضرر سایت تمام شود.

robots.txt چیست؟ تعریف و اهمیت آن در سئو

فایل robots.txt یک سند متنی ساده است که در ریشه (root) وبسایت قرار میگیرد و وظیفه اصلی آن مدیریت نحوه دسترسی خزندههای موتورهای جستجو به صفحات سایت است. به زبان دیگر، این فایل نقش راهنما را ایفا میکند و مشخص میسازد که کدام بخشها برای ایندکس شدن در دسترس باشند و کدام بخشها از دید رباتها پنهان بمانند. تصور کنید در یک ساختمان بزرگ، نگهبانی وجود داشته باشد که به بازدیدکنندگان میگوید کدام اتاقها باز هستند و کدامها قفل شدهاند. فایل robots.txt دقیقاً همان نگهبان دیجیتال است که ورودیها را کنترل میکند. اهمیت این فایل در استراتژی سئو به اندازهای است که حتی گوگل در مستندات رسمی خود تأکید کرده مدیریت صحیح robots.txt میتواند کیفیت ایندکس و استفاده بهینه از بودجه خزش (Crawl Budget) را تضمین کند.

robots txt دقیقا چه کاری انجام میدهد؟

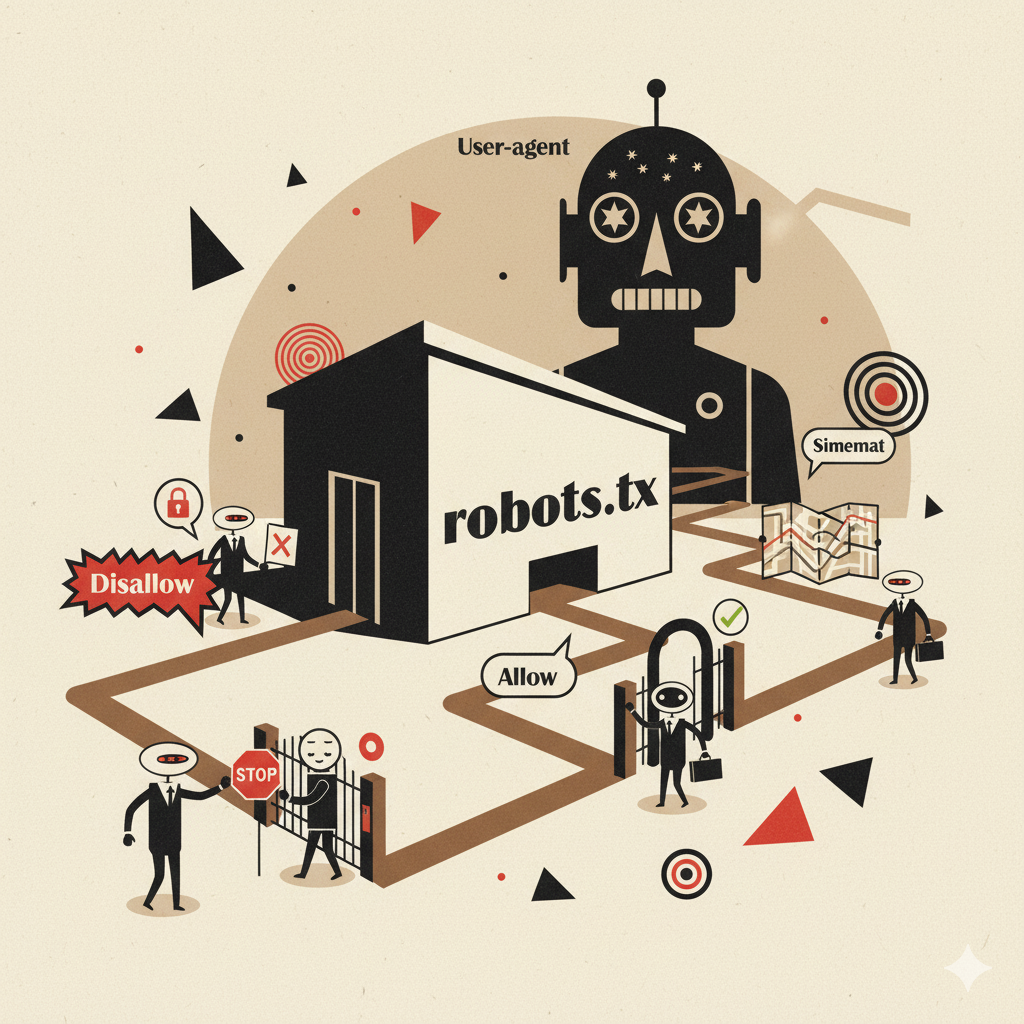

وظیفه اصلی فایل robots.txt «هدایت خزندهها» است. هر زمان یک ربات موتور جستجو وارد وبسایت شما میشود، قبل از هر اقدامی ابتدا به دنبال فایل robots.txt میگردد. در این فایل، با استفاده از دستوراتی مانند User-agent، Disallow، Allow و Sitemap مشخص میشود که چه محتوایی برای خزندهها قابل دسترسی باشد و چه بخشهایی نباید بررسی شوند. برای مثال، میتوان صفحات تکراری، فایلهای سیستمی یا بخشهای مدیریتی را از دسترس گوگل خارج کرد تا تمرکز رباتها روی محتوای ارزشمندتر قرار بگیرد. برای روشنتر شدن موضوع، فرض کنید یک کتابخانه عظیم دارید و یک تیم بازدیدکننده میخواهد همه کتابها را بررسی کند. اگر اجازه دهید آنها وقت خود را روی برگههای پیشنویس و صفحات آزمایشی بگذارند، منابعشان هدر میرود. اما اگر راهنمایی شوند تا فقط کتابهای مهم و ارزشمند را ببینند، بهرهوری کارشان بالاتر میرود. robots.txt همین نقش راهنما را دارد و از هدر رفتن منابع خزندهها جلوگیری میکند. نتیجه نهایی هم چیزی جز بهبود سئو و افزایش سرعت ایندکس نخواهد بود.

چرا گوگل و موتورهای جستجو به آن توجه میکنند؟

گوگل و سایر موتورهای جستجو به robots.txt اهمیت میدهند چون این فایل نوعی قرارداد میان وبسایت و خزندههاست. وقتی رباتها به این فایل مراجعه میکنند، در واقع دستورالعملی رسمی دریافت میکنند که کجا مجاز به ورود هستند و کجا نه. هرچند robots.txt یک «قانون الزامآور مطلق» نیست و برخی خزندههای مخرب ممکن است آن را نادیده بگیرند، اما برای موتورهای جستجویی مثل گوگل و بینگ یک استاندارد پذیرفتهشده است. برای اینکه اهمیت این موضوع روشنتر شود، تصور کنید که یک نمایشگاه برگزار کردهاید. اگر از همان ابتدا به بازدیدکنندگان نگویید کدام غرفهها عمومی هستند و کدام بخشها فقط برای کارکنان باز است، حتماً هرجومرجی به وجود میآید. موتورهای جستجو هم همینطور عمل میکنند؛ بدون راهنمایی robots.txt، ممکن است به صفحاتی بروند که نباید، یا از صفحاتی مهم عبور کنند. به همین دلیل است که گوگل حتی ابزارهایی مانند تست robots.txt در سرچ کنسول ارائه کرده تا وبمسترها مطمئن شوند همهچیز طبق برنامه جلو میرود.

فرق متا تگ robots با robots.txt چیست ؟

یکی از سوالات رایج این است که تفاوت فایل robots.txt با meta robots tag چیست. هر دو ابزار برای کنترل ایندکس شدن محتوا بهکار میروند، اما کاربردشان متفاوت است:

- robots.txt در سطح کلان عمل میکند و مسیر دسترسی به پوشهها یا فایلهای خاص را برای رباتها مسدود یا آزاد میسازد. به عبارت دیگر، این فایل «اجازه ورود» یا «ممانعت کلی» را مشخص میکند.

- Meta Robots Tag در سطح صفحه قرار میگیرد و معمولاً در بخش

<head>کد HTML اضافه میشود. این تگ بهطور جزئی مشخص میکند که یک صفحه خاص ایندکس شود یا خیر، و همچنین آیا لینکهای داخل آن دنبال شوند یا نه (با دستوراتی مثلnoindexیاnofollow).

برای درک بهتر تفاوت، تصور کنید robots.txt همان تابلوی ورودی یک ساختمان است که مشخص میکند چه کسانی حق ورود به کدام طبقات را دارند. در مقابل، meta robots tag مثل برچسبهایی است که روی هر اتاق نصب شده و به بازدیدکننده میگوید داخل این اتاق میتواند عکس بگیرد یا خیر. بنابراین، هر دو مکمل یکدیگرند و استفاده هوشمندانه از ترکیب آنها میتواند مدیریت دقیقتری بر فرآیند ایندکس ایجاد کند.

| ویژگیها | robots.txt (فایل) | Meta Robots Tag (تگ HTML) |

|---|---|---|

| سطح کنترل | کلی (پوشهها و فایلها) | جزئی (در سطح یک صفحه مشخص) |

| محل قرارگیری | در ریشه (root) وبسایت | در بخش <head> کد HTML صفحه |

| دستورات رایج | User-agent، Disallow، Allow، Sitemap | index/noindex، follow/nofollow |

| هدف اصلی | جلوگیری یا اجازه دسترسی به مسیرها | کنترل نحوه ایندکس و دنبال کردن لینکها در صفحه |

| کاربرد در سئو | مدیریت بودجه خزش و جلوگیری از ایندکس صفحات اضافی | کنترل دقیق ایندکس صفحات مهم یا حساس |

ساختار فایل robots.txt چگونه است؟

فایل robots.txt در ظاهر بسیار ساده است، اما همین سادگی اگر با دانش کافی همراه نباشد میتواند باعث بروز خطاهای جدی در سئو شود. این فایل از مجموعهای از دستورات تشکیل میشود که هرکدام نقش مشخصی دارند. زمانی که خزندههای موتورهای جستجو وارد سایت میشوند، ابتدا به سراغ همین فایل میروند تا بفهمند کدام مسیرها باز هستند و کدام بخشها محدود شدهاند. به همین دلیل، درک درست از ساختار فایل robots.txt برای هر مدیر سایت یا متخصص سئو ضروری است.

معرفی اجزای اصلی (User-agent, Disallow, Allow, Sitemap)

چهار بخش کلیدی در فایل robots.txt بیشترین نقش را دارند و درک درست از آنها به معنی کنترل کامل بر نحوه خزش سایت است:

- User-agent: این دستور مشخص میکند که قوانین بعدی برای کدام خزنده اعمال میشود. بهطور مثال، اگر بنویسیم

User-agent: Googlebotیعنی دستوراتی که بعد از آن میآیند فقط برای ربات گوگل معتبر هستند. اگر بنویسیمUser-agent: *یعنی همه رباتها مشمول این قوانین خواهند شد. به بیان ساده، این بخش مثل برچسب روی یک بسته پستی است که مشخص میکند بسته مخصوص چه کسی است. - Disallow: با این دستور به رباتها میگوییم وارد یک مسیر خاص نشوند. برای مثال

Disallow: /private/به این معناست که محتوای داخل پوشه private نباید خزیده شود. اهمیت این بخش در این است که میتوانیم بخشهای بیارزش یا حساس سایت (مثل صفحات مدیریتی یا فایلهای تکراری) را از دید موتورهای جستجو مخفی کنیم. این دستور مثل تابلو «ورود ممنوع» است که جلوی یک کوچه نصب شده باشد. - Allow: گاهی نیاز داریم که در دل یک مسیر مسدود، بخشی همچنان در دسترس خزندهها باشد. دستور Allow این امکان را فراهم میکند. برای مثال اگر کل پوشه

/wp-admin/را بلاک کرده باشیم اما بخواهیم فایلadmin-ajax.phpهمچنان قابل دسترسی باشد، از Allow استفاده میکنیم. این دستور مثل یک مسیر اضطراری باز است در حالی که کل خیابان بسته شده. - Sitemap: یکی از مهمترین قابلیتهای فایل robots.txt معرفی آدرس نقشه سایت (XML Sitemap) است. این نقشه دید جامعی از ساختار سایت به موتورهای جستجو میدهد و باعث میشود سریعتر و بهتر صفحات را شناسایی کنند. نوشتن آدرس نقشه سایت در robots.txt مانند این است که به بازدیدکنندهای تازهوارد، یک نقشه کامل شهر بدهید تا راحتتر مسیرها را پیدا کند.

| دستور | کاربرد اصلی | نمونه کد |

|---|---|---|

| User-agent | تعیین ربات هدف (مثلاً Googlebot یا همه رباتها) | User-agent: * |

| Disallow | جلوگیری از دسترسی خزنده به مسیر یا پوشه | Disallow: /wp-admin/ |

| Allow | اجازه دسترسی به بخش مشخصی از مسیر بلاکشده | Allow: /wp-admin/admin-ajax.php |

| Sitemap | معرفی آدرس نقشه سایت برای درک بهتر ساختار کلی | Sitemap: https://example.com/sitemap.xml |

این اجزای ساده اما کلیدی اگر درست استفاده شوند، کنترل دقیقی بر فرآیند ایندکس و بهینهسازی سایت فراهم میکنند. اما اگر بدون دانش کافی از آنها استفاده شود، ممکن است بخشهای مهم سایت از نتایج گوگل حذف شوند یا برعکس، بخشهای بیارزش وارد نتایج شوند.

علائم مهم در فایل robots.txt و کاربرد آنها

برای نوشتن دستورهای robots.txt از چند علامت ساده استفاده میشود که هر کدام نقش مهمی دارند. اگر این علائم درست فهمیده نشوند، ممکن است باعث مسدود شدن ناخواسته صفحات مهم یا برعکس، باز ماندن مسیرهایی شوند که باید بلاک شوند.

| علامت | کاربرد | مثال | توضیح |

|---|---|---|---|

/ | نشاندهنده ریشه یا مسیر پوشه/فایل است | Disallow: /admin/ | همه مسیرهایی که بعد از /admin/ قرار دارند بلاک میشوند |

* | به معنای «هر چیزی» است (Wildcard) | Disallow: /*.php | همه فایلهایی با پسوند .php مسدود میشوند |

$ | برای مشخص کردن انتهای URL استفاده میشود | Disallow: /test$ | فقط URL دقیقا برابر با /test بلاک میشود، نه /test/page |

# | برای نوشتن توضیح (کامنت) به کار میرود | # این بخش مخصوص تست است | رباتها این خط را نادیده میگیرند، فقط برای توضیحات داخلی است |

: | جداکننده دستور و مقدار است | User-agent: * | بعد از User-agent با استفاده از : نوع ربات مشخص میشود |

مثالهایی از کدهای کاربردی robots.txt

برای اینکه درک بهتری از ساخت robots.txt داشته باشید، چند مثال کاربردی را مرور میکنیم. برای هر بخش دو نمونه مختلف آورده شده تا کاربردها واضحتر شود:

مثال ۱: بلاک کردن پوشه مدیریت وردپرس (نمونه ۱)

همه خزندهها از دسترسی به پوشه wp-admin منع شدهاند، اما فایل ضروری admin-ajax.php همچنان قابل دسترسی باقی مانده است.

مثال ۲: بلاک کردن پوشه مدیریت وردپرس (نمونه ۲)

اینجا فقط ربات گوگل از دسترسی به پوشه مدیریتی منع شده و سایر خزندهها همچنان دسترسی دارند.

مثال ۳: بلاک کردن یک صفحه خاص (نمونه ۱)

این دستور مانع خزش صفحه test-page.html توسط همه خزندهها میشود.

مثال ۴: بلاک کردن یک صفحه خاص (نمونه ۲)

این دستور فقط ربات بینگ را از دسترسی به صفحه old-page.html منع میکند.

مثال ۵: معرفی نقشه سایت (نمونه ۱)

نقشه اصلی سایت معرفی میشود تا موتورهای جستجو سریعتر صفحات را بشناسند.

مثال ۶: معرفی نقشه سایت (نمونه ۲)

دو نقشه سایت جداگانه (برای نوشتهها و صفحات) معرفی شده تا ایندکس بهتر انجام گیرد.

مثال ۷: بلاک کردن یک پوشه خاص (نمونه ۱)

پوشه تصاویر خصوصی از ایندکس خارج میشود.

مثال ۸: بلاک کردن یک پوشه خاص (نمونه ۲)

پوشه drafts (پیشنویسها) مسدود میشود تا محتوای ناقص ایندکس نشود.

مثال ۹: بلاک کردن همه خزندهها از دسترسی به کل سایت (نمونه ۱)

قفل کامل سایت؛ هیچ صفحهای ایندکس نمیشود.

مثال ۱۰: بلاک کردن همه خزندهها از دسترسی به کل سایت (نمونه ۲)

همه سایت مسدود شده اما یک صفحه خاص (maintenance.html) باز مانده است.

مثال ۱۱: بلاک کردن یک خزنده خاص (نمونه ۱)

دسترسی ربات تصاویر گوگل به کل سایت مسدود میشود.

مثال ۱۲: بلاک کردن یک خزنده خاص (نمونه ۲)

خزنده AhrefsBot (ابزار بررسی بکلینکها) از دسترسی به سایت منع میشود.

مثال ۱۳: اجازه دسترسی به یک پوشه خاص و بلاک کردن سایر بخشها (نمونه ۱)

همه سایت مسدود میشود به جز پوشه public.

مثال ۱۴: اجازه دسترسی به یک پوشه خاص و بلاک کردن سایر بخشها (نمونه ۲)

اینجا تنها بخش وبلاگ برای خزندهها باز است و باقی سایت مسدود شده.

مثال ۱۵: بلاک کردن پارامترهای خاص در URL (نمونه ۱)

جلوی ایندکس شدن صفحات تکراری ناشی از پارامتر replytocom گرفته میشود.

مثال ۱۶: بلاک کردن پارامترهای خاص در URL (نمونه ۲)

این دستور جلوی ایندکس شدن URLهایی با پارامتر sessionid را میگیرد.

مثال ۱۷: بلاک کردن فایل PDF خاص (نمونه ۱)

این فایل PDF از دسترس خزندهها خارج میشود.

مثال ۱۸: بلاک کردن فایل PDF خاص (نمونه ۲)

اینجا فایل راهنمای قدیمی سایت از ایندکس خارج شده تا نسخه جدید جایگزین شود.

این مثالها نشان میدهد که فایل robots.txt میتواند با چند خط ساده، مدیریت دقیقی بر فرآیند خزش ایجاد کند. بسته به شرایط هر سایت، میتوان از این دستورها برای جلوگیری از ایندکس شدن محتوای بیارزش، حفظ امنیت یا بهینهسازی بودجه خزش استفاده کرد.

چه زمانی به فایل robots.txt نیاز داریم؟

استفاده از فایل robots.txt همیشه اجباری نیست، اما در بسیاری از مواقع میتواند تفاوت بزرگی در کیفیت ایندکس و بهینهسازی سئو ایجاد کند. در واقع این فایل زمانی اهمیت پیدا میکند که بخواهید کنترل بیشتری بر روی نحوه دسترسی موتورهای جستجو به محتوای سایت خود داشته باشید. درست مثل اینکه شما مدیر یک فروشگاه بزرگ باشید؛ همه اتاقها و انبارها را در اختیار مشتریها قرار نمیدهید، بلکه فقط ویترین و بخشهای اصلی را برای نمایش باز میکنید. فایل robots.txt دقیقاً همین نقش را در دنیای وب ایفا میکند.

جلوگیری از ایندکس بخشهای غیرضروری سایت

یکی از مهمترین کاربردهای فایل robots.txt این است که جلوی ایندکس شدن صفحاتی را بگیریم که ارزش چندانی برای کاربر یا سئو ندارند. بهعنوان مثال، صفحات مدیریتی مانند /wp-admin/، صفحات تستی، نسخههای پرینت، فایلهای موقتی یا حتی صفحات تکراری نباید در نتایج گوگل ظاهر شوند. ایندکس شدن چنین بخشهایی میتواند کیفیت نتایج جستجو را پایین بیاورد و حتی تجربه کاربری را تحت تأثیر قرار دهد. برای درک بهتر، تصور کنید در یک نمایشگاه بزرگ غرفهای وجود دارد که فقط وسایل خراب یا نمونههای آزمایشی قرار دارد. اگر بازدیدکنندگان به آن بخش هدایت شوند، نه تنها وقتشان تلف میشود بلکه تصویر برند شما هم آسیب میبیند. ایندکس شدن صفحات بیارزش در سایت دقیقاً همین تأثیر منفی را بهجا میگذارد.

جدول مقایسه صفحات ضروری و غیرضروری برای ایندکس

| نوع صفحه | مثالها | نیاز به ایندکس |

|---|---|---|

| صفحات ضروری | صفحه محصولات، مقالات وبلاگ، صفحه تماس | بله |

| صفحات غیرضروری | پوشه مدیریت، صفحات تستی، فایلهای PDF قدیمی | خیر |

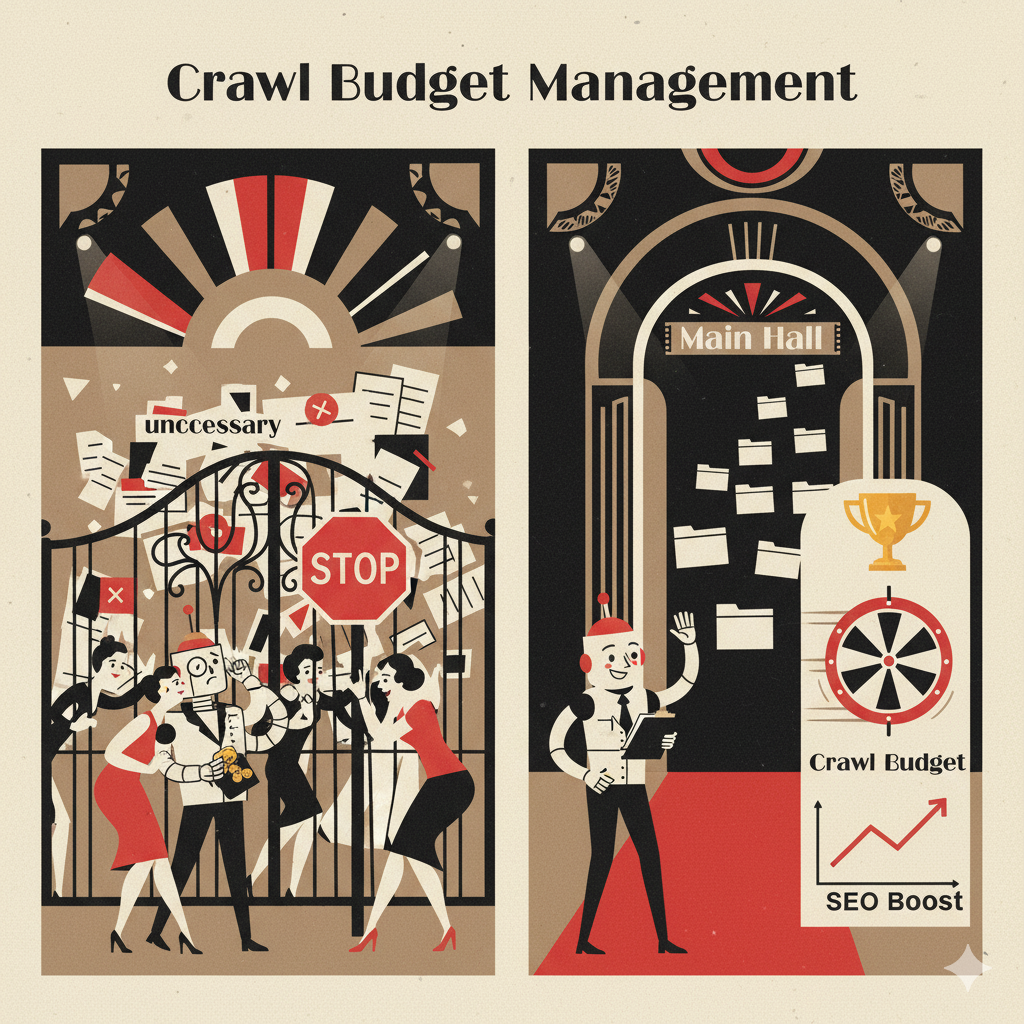

توضیح و تعریف مختصر بودجه خزش (Crawl Budget)

بودجه خزش یا Crawl Budget به تعداد صفحاتی گفته میشود که یک موتور جستجو مانند گوگل در یک بازه زمانی مشخص از سایت شما خزش و ایندکس میکند. این مفهوم را میتوان به بودجه مالی تشبیه کرد؛ شما هر ماه مقدار مشخصی پول برای هزینهها دارید و باید آن را به بهترین شکل خرج کنید. موتورهای جستجو هم منابع محدودی دارند و نمیتوانند همه صفحات جهان را بیپایان بررسی کنند، بنابراین باید تصمیم بگیرند کدام صفحات ارزش بیشتری دارند. برای مثال، فرض کنید گوگل روزانه ۱۰۰ صفحه از سایت شما را بررسی میکند. اگر ۶۰ صفحه از این تعداد مربوط به صفحات بیارزش مانند تگهای تکراری یا پارامترهای بیمصرف باشند، فقط ۴۰ صفحه واقعی و ارزشمند شانس ایندکس شدن پیدا میکنند. این موضوع مثل این است که بخش زیادی از بودجه ماهانه خود را صرف خرید وسایل بیمصرف کنید و در نهایت برای خریدهای اصلی پولی باقی نماند.

پیشنهاد میکنم برای فهم بهتر این قسمت ، مقاله ایندکس کردن سایت چیست ؟ را مطالعه بفرمایید تا کمی عمیق تر به مفهوم کرال بادجت پی ببرید !

مدیریت بودجه خزش (Crawl Budget)

یکی از اصلیترین دلایل استفاده از robots.txt مدیریت هوشمندانه بودجه خزش است. همانطور که گوگل در مستندات رسمی خود درباره Crawl Budget توضیح داده، مدیریت صحیح دسترسی رباتها کمک میکند بودجه خزش روی صفحات مهمتر متمرکز شود. وقتی صفحات غیرضروری را با استفاده از دستوراتی مانند Disallow مسدود کنید، بودجه خزش بهطور خودکار صرف صفحات کلیدی و ارزشمند خواهد شد. این موضوع بهویژه برای سایتهای بزرگ با هزاران صفحه اهمیت حیاتی دارد. بهعنوان نمونه، یک فروشگاه اینترنتی با هزاران محصول را در نظر بگیرید. این فروشگاه ممکن است صفحات فیلتر زیادی داشته باشد که ترکیبهای مختلفی از رنگ، سایز یا برند را نمایش میدهند. اگر همه این صفحات توسط گوگل ایندکس شوند، بودجه خزش بخش زیادی از سایت صرف این URLهای کمارزش میشود. اما با تنظیم درست robots.txt میتوان جلوی این هدررفت را گرفت و خزندهها را به سمت محصولات اصلی هدایت کرد.

تأثیر مدیریت بودجه خزش

| وضعیت سایت | نتیجه |

| بدون مدیریت بودجه خزش | ایندکس شدن صفحات بیارزش، هدررفت منابع |

| با مدیریت درست در robots.txt | تمرکز خزندهها بر صفحات کلیدی، بهبود رتبهبندی |

مدیریت Crawl Budget در نهایت باعث میشود:

- صفحات مهم سریعتر ایندکس شوند.

- کیفیت نتایج سایت در گوگل افزایش یابد.

- منابع سرور بهینهتر مصرف شوند.

به همین دلیل، استفاده از robots.txt نه تنها یک ابزار کمکی، بلکه بخشی حیاتی از استراتژی حرفهای سئو محسوب میشود.

نحوه ایجاد و ویرایش فایل robots.txt

فایل robots.txt در ظاهر یک فایل متنی ساده است، اما در واقع یکی از ابزارهای کلیدی برای مدیریت نحوه تعامل موتورهای جستجو با سایت محسوب میشود. نکته جالب اینجاست که برخلاف تصور بسیاری از افراد، ایجاد یا ویرایش این فایل کار پیچیدهای نیست و با چند روش ساده میتوان آن را انجام داد. چه شما مدیر یک سایت کوچک باشید یا مالک یک فروشگاه اینترنتی با هزاران محصول، دانستن روشهای ایجاد و ویرایش robots.txt برای بهینهسازی سئو ضروری است.

ایجاد دستی با Notepad یا ابزارهای آنلاین

سادهترین و سنتیترین روش برای ساخت فایل robots.txt استفاده از یک ویرایشگر متن مانند Notepad در ویندوز یا TextEdit در مک است. شما یک فایل متنی جدید باز میکنید، دستورهای مورد نظر (مثل Disallow یا Allow) را در آن مینویسید و سپس فایل را با نام دقیق robots.txt ذخیره میکنید. در نهایت، باید این فایل را در پوشه اصلی هاست (Root Directory) آپلود کنید. مسیر نهایی باید چیزی شبیه به این باشد:

اگر این آدرس را در مرورگر وارد کنید و محتوای فایل را ببینید، یعنی همهچیز درست انجام شده است.

این روش به شما کنترل کامل میدهد، اما خطر خطا هم در آن بیشتر است. یک اشتباه کوچک، مثل اضافه کردن یک علامت غیرضروری، میتواند باعث شود صفحات کلیدی سایت از ایندکس خارج شوند. به همین دلیل منابعی مانند راهنمای رسمی گوگل برای فایل robots.txt توصیه میکنند که پس از ایجاد فایل، حتماً آن را تست کنید.

برای کسانی که نمیخواهند با دستورات بهصورت مستقیم سر و کار داشته باشند، ابزارهای آنلاین وجود دارند. به این ابزارها Robots.txt Generators میگویند و معمولاً رابط کاربری سادهای دارند. شما فقط گزینهها را انتخاب میکنید (مثل بلاک کردن پوشه خاص یا اجازه دادن به یک مسیر) و ابزار، فایل استاندارد را برایتان تولید میکند. وبسایتهای سئو معتبر مثل Yoast و SmallSEOtools چنین ابزارهایی ارائه میدهند. این ابزارها احتمال خطا را کاهش داده و بهویژه برای کاربران تازهکار بسیار مناسب هستند.

جدول مقایسه ایجاد فایل robots.txt بهصورت دستی و با ابزار آنلاین

| روش | مزایا | معایب |

|---|---|---|

| ایجاد دستی | کنترل کامل، انعطافپذیری بالا | احتمال خطای انسانی، نیاز به دانش دستورات |

| ابزار آنلاین | کاربری ساده، کاهش خطا، مناسب برای مبتدیان | محدودیت در شخصیسازی پیشرفته |

مدیریت robots.txt در وردپرس و CMSهای دیگر

امروزه بیشتر وبسایتها بر پایه سیستمهای مدیریت محتوا (CMS) ساخته میشوند و این سیستمها راهکارهای سادهای برای مدیریت robots.txt دارند. در وردپرس، دو روش اصلی وجود دارد:

ایجاد یا ویرایش دستی در هاست: شما میتوانید فایل robots.txt را مثل هر سایت دیگری در پوشه Root قرار دهید. این روش همانند روش دستی است اما از طریق پنل هاست (مثل cPanel یا DirectAdmin) انجام میشود.

استفاده از افزونهها: افزونههای سئو مثل Yoast SEO یا Rank Math امکاناتی برای مدیریت robots.txt در اختیار شما میگذارند. کافی است به تنظیمات این افزونهها بروید و دستورات دلخواه خود را وارد کنید. مزیت این روش این است که بدون نیاز به ورود به هاست، از داخل داشبورد وردپرس میتوانید فایل را ویرایش کنید. علاوه بر این، برخی افزونهها حتی هشدار میدهند اگر دستورات شما مطابق با استانداردها نباشد.

برای مثال، فرض کنید میخواهید دسترسی به پوشه wp-admin را ببندید اما فایل admin-ajax.php همچنان در دسترس باشد. افزونه Yoast SEO به شما اجازه میدهد این دستورات را به راحتی اضافه کنید و در صورت وجود اشتباه، هشدار میدهد.

در سایر CMSها مثل جوملا یا دروپال هم ماژولها و افزونههایی وجود دارند که همین قابلیت را ارائه میدهند. تفاوت اصلی آنها فقط در رابط کاربری است، اما اصل ماجرا یکی است: فایل باید در پوشه Root باشد و نام آن دقیقاً robots.txt باشد.

مقایسه مدیریت robots.txt در سیستمهای مختلف

| CMS | روش مدیریت فایل robots.txt | مزایا |

|---|---|---|

| وردپرس | دستی در هاست یا از طریق افزونههایی مثل Yoast | ساده، سریع، هشدار در صورت خطا |

| جوملا | ماژولهای اختصاصی یا ایجاد دستی در هاست | انعطافپذیری بالا |

| دروپال | ماژولهای سئو و مدیریت فایلها در Root | مناسب برای توسعهدهندگان |

در نتیجه، چه از روش دستی استفاده کنید و چه از ابزارهای آنلاین یا افزونههای CMS، نکته کلیدی این است که فایل robots.txt باید همیشه در ریشه سایت باشد و بهراحتی توسط خزندهها در دسترس قرار گیرد. استفاده از منابع معتبر مثل مستندات گوگل یا راهنمای Yoast میتواند از بروز خطا جلوگیری کرده و اطمینان حاصل کند که فایل شما طبق بهترین practices سئو تنظیم شده است.

تست و اعتبارسنجی فایل robots.txt

نوشتن فایل robots.txt تنها اولین قدم است. اگرچه ساختن آن ساده به نظر میرسد، اما اهمیت واقعی زمانی مشخص میشود که مطمئن شوید این فایل دقیقاً همانطور که انتظار دارید عمل میکند. حتی یک دستور اشتباه میتواند نتایج فاجعهباری به همراه داشته باشد؛ مثلاً ممکن است کل سایت شما از ایندکس خارج شود یا برعکس، صفحات بیارزش وارد نتایج جستجو شوند. بنابراین تست و اعتبارسنجی فایل robots.txt بخش جداییناپذیر از استراتژی حرفهای سئو محسوب میشود.

ابزار تست robots.txt گوگل سرچ کنسول

گوگل ابزاری اختصاصی برای تست فایل robots.txt در Google Search Console فراهم کرده است که یکی از مطمئنترین روشها برای بررسی صحت این فایل به شمار میرود. این ابزار به شما امکان میدهد:

محتوای کامل فایل robots.txt خود را مشاهده کنید.

یک URL خاص را وارد کنید و بررسی کنید آیا خزنده گوگل (Googlebot) اجازه دسترسی به آن دارد یا خیر.

خطاهای احتمالی در دستورات را شناسایی کنید.

برای مثال، فرض کنید یک فروشگاه اینترنتی دارید و بهطور اشتباه پوشه /products/ را مسدود کردهاید. با استفاده از ابزار تست میتوانید URL یکی از محصولات را وارد کنید. اگر پیام «Blocked» دریافت کنید، یعنی این بخش از دسترس گوگل خارج شده و باید فوراً اصلاح شود. در مقابل، اگر پیام «Allowed» نمایش داده شود، یعنی صفحه مورد نظر بهدرستی قابل خزش است.

این ابزار بهخصوص برای سایتهای بزرگ که هزاران صفحه دارند اهمیت دوچندانی دارد. چرا که بررسی دستی امکانپذیر نیست و تنها با تست خودکار میتوان از صحت عملکرد اطمینان پیدا کرد. به همین دلیل، منابع معتبر بینالمللی مانند مستندات رسمی گوگل توصیه میکنند که بعد از هر بار تغییر در فایل robots.txt، حتماً فایل خود را با ابزار گوگل تست کنید.

نمونه عملی تست URL در سرچ کنسول

فرض کنید صفحهای با آدرس زیر دارید:

بعد از وارد کردن این آدرس در ابزار تست، دو حالت ممکن است رخ دهد:

Allowed: صفحه برای گوگل باز است و ایندکس خواهد شد.

Blocked: صفحه توسط یکی از دستورات robots.txt مسدود شده است و باید بررسی شود که آیا این کار عمدی بوده یا یک خطای تنظیمی.

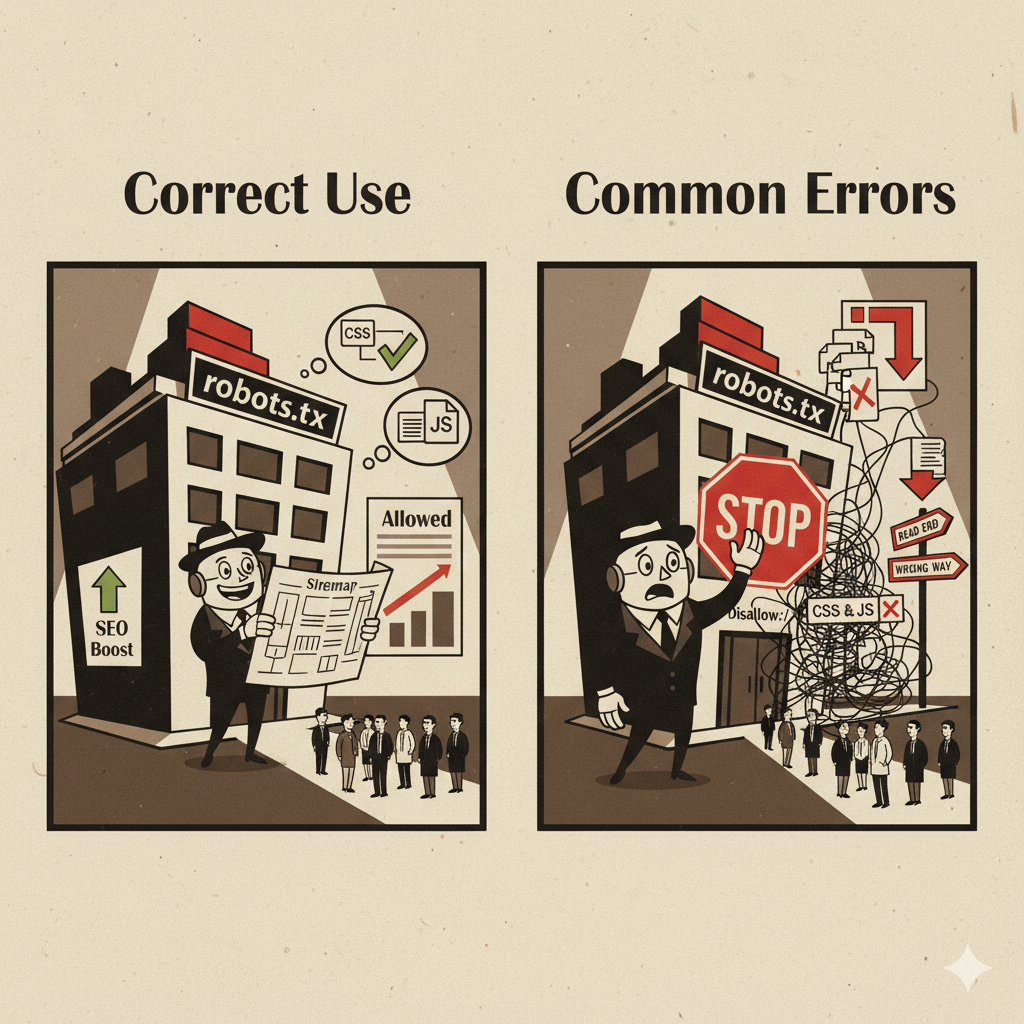

خطاهای رایج و نحوه رفع آنها

بسیاری از مشکلات سئو به دلیل خطاهای ساده اما تأثیرگذار در فایل robots.txt به وجود میآیند. شناخت این خطاها و راهحلهای آنها کمک میکند از آسیبهای جدی جلوگیری کنید.

مسدود کردن کل سایت بهطور ناخواسته

استفاده از دستورDisallow: /به معنای مسدود کردن کل سایت است. اگر این دستور به اشتباه در فایل قرار گیرد، هیچ صفحهای ایندکس نخواهد شد. برای رفع مشکل باید مسیرها را دقیقاً مشخص کنید و فقط پوشههای غیرضروری را ببندید.تناقض بین robots.txt و meta robots tag

گاهی در فایل robots.txt دسترسی به یک صفحه باز است، اما در همان صفحه از تگ meta robots با دستورnoindexاستفاده شده است. این تناقض باعث سردرگمی موتورهای جستجو میشود. بهترین راه هماهنگسازی استراتژی و استفاده صحیح از هر دو ابزار است.مسدود کردن منابع حیاتی (CSS و JavaScript)

اگر فایلهای CSS یا JS مسدود شوند، گوگل قادر نخواهد بود ظاهر و عملکرد واقعی سایت را درک کند. این مشکل نه تنها روی رتبهبندی تأثیر منفی میگذارد، بلکه تجربه کاربری را هم تضعیف میکند. راهحل این است که مطمئن شوید مسیر فایلهای حیاتی همیشه باز باشند.اشتباه در استفاده از نمادها و کاراکترها

کاراکترهایی مثل/,*یا$اگر درست استفاده نشوند، ممکن است نتایج پیشبینینشدهای ایجاد کنند. برای مثال، استفاده از/*میتواند همه فایلهای یک مسیر را مسدود کند، حتی اگر فقط قصد داشته باشید یک فایل خاص را بلاک کنید. برای جلوگیری از این خطاها باید دستورات را قبل از انتشار، با ابزار گوگل تست کنید.

خطاهای رایج در robots.txt و راهحلها

| خطای رایج | توضیح مشکل | راهحل پیشنهادی |

|---|---|---|

| Disallow: / | مسدود کردن کل سایت بهطور ناخواسته | مشخص کردن مسیرهای دقیق به جای استفاده کلی |

| تناقض با meta robots | دستورات متناقض بین فایل و تگ صفحه | هماهنگسازی استراتژی ایندکس |

| مسدود کردن CSS یا JS | موتور جستجو نمیتواند ظاهر سایت را کامل درک کند | باز گذاشتن مسیر فایلهای ضروری |

| استفاده نادرست از * یا $ | مسدود شدن مسیرهای بیشتر از حد نیاز | تست دقیق در ابزار سرچ کنسول |

بهطور خلاصه، تست و اعتبارسنجی فایل robots.txt تضمین میکند که سایت شما در مسیر درست قرار دارد. این کار مانند چکاپ دورهای برای سلامت وبسایت است. اگر این مرحله را نادیده بگیرید، حتی بهترین استراتژیهای سئو هم ممکن است بینتیجه بمانند. بنابراین توصیه میشود بعد از هر تغییر، فایل خود را با ابزارهای رسمی گوگل یا سرویسهای معتبر بینالمللی مانند SEMrush و Moz بررسی کنید تا مطمئن شوید همهچیز طبق استانداردها پیش میرود.

نکات حرفهای و بهترین شیوههای استفاده از robots.txt

فایل robots.txt مثل یک راهنمای ترافیک در یک شهر شلوغ است. اگر بهدرستی طراحی شود، مسیرها را برای ماشینها (خزندههای موتور جستجو) مشخص میکند و آنها را به سمت خیابانهای اصلی و پرکاربرد هدایت میکند. اما اگر با بیدقتی نوشته شود، ممکن است به جای هدایت درست، ماشینها را به کوچههای بنبست یا مسیرهای غیرضروری بفرستد. نتیجه این اتفاق چیزی نیست جز از دست رفتن بودجه خزش و کاهش شانس دیده شدن صفحات مهم سایت. بنابراین یادگیری بهترین practices و اجتناب از خطاهای رایج در تنظیم این فایل، یکی از پایههای سئو تکنیکال محسوب میشود.

کارهایی که باید انجام دهید

قرار دادن فایل در پوشه Root

فایل robots.txt همیشه باید در پوشه اصلی (Root Directory) سایت قرار گیرد. برای مثال:

اگر این فایل در پوشههای داخلی قرار داده شود، موتورهای جستجو آن را پیدا نمیکنند. درست مثل این است که نقشه راهنمای یک نمایشگاه بزرگ را در یکی از اتاقهای خصوصی قرار دهید؛ بازدیدکنندگان هیچوقت آن را نخواهند دید.

میتوانید برای اینکه راحت تر با قسمت سورس صفحه و html ها کار بکنید ، مقاله آموزش HTML برای مبتدیان را مطالعه بفرمایید !

معرفی نقشه سایت (Sitemap)

اضافه کردن نقشه سایت XML در فایل robots.txt باعث میشود موتورهای جستجو سریعتر و هوشمندانهتر به صفحات کلیدی شما دسترسی پیدا کنند. برای مثال:

این کار مثل این است که به مسافری تازهوارد یک نقشه کامل از شهر بدهید تا بدون اتلاف وقت به مقصد برسد. همانطور که Moz در راهنمای خود اشاره کرده، معرفی نقشه سایت در robots.txt یکی از سادهترین و در عین حال مؤثرترین تکنیکهای سئو است.

باز گذاشتن منابع حیاتی (CSS و JS)

هرگز منابعی مانند CSS و JavaScript را بلاک نکنید. گوگل برای درک درست ساختار و تجربه کاربری صفحات به این فایلها نیاز دارد. تصور کنید به یک معمار فقط نقشه دیوارها را بدهید ولی جزئیات پنجرهها و سقف را مخفی کنید؛ قطعاً نمیتواند تصویر درستی از ساختمان بسازد. همین اتفاق در وب هم رخ میدهد.بهروزرسانی و تست منظم فایل

فایل robots.txt نباید ثابت باقی بماند. هر بار که ساختار سایت تغییر میکند، این فایل هم باید بازبینی و تست شود. ابزارهایی مثل Google Search Console یا پلتفرمهایی مثل SEMrush امکان تست سریع دستورات را فراهم میکنند. این تستها مثل یک معاینه دورهای هستند که جلوی بروز بیماریهای جدی (خطاهای ایندکس) را میگیرند.استفاده از قوانین شفاف و هدفمند

قوانین فایل باید دقیق و هدفمند نوشته شوند. برای مثال، بهجای مسدود کردن کل پوشهها، فقط بخشهای غیرضروری را بلاک کنید:

این رویکرد باعث میشود هم امنیت و بهینهسازی حفظ شود و هم عملکرد سایت دچار اختلال نشود.

بهترین کارهایی که باید انجام دهید

| اقدام حرفهای | چرا مهم است؟ | مثال عملی |

|---|---|---|

| قرار دادن فایل در Root | دسترسی سریع موتورهای جستجو به فایل | https://example.com/robots.txt |

| معرفی نقشه سایت | هدایت بهتر خزندهها به صفحات مهم | Sitemap: https://example.com/sitemap.xml |

| باز گذاشتن منابع حیاتی (CSS/JS) | درک بهتر گوگل از ظاهر و عملکرد سایت | عدم بلاک /wp-content/themes/ |

| بهروزرسانی و تست منظم | جلوگیری از خطاهای ناخواسته در ایندکس | تست در Google Search Console |

| قوانین شفاف و هدفمند | بهینهسازی بودجه خزش و حفظ سئو | Disallow: /test/ |

اشتباهات رایج که باید اجتناب کنید

بلاک کردن کل سایت به اشتباه

دستورDisallow: /به معنای مسدود کردن کل سایت است. این خطا بیشتر در مراحل اولیه توسعه رخ میدهد و اگر فراموش شود حذف گردد، میتواند باعث سقوط کامل سایت از نتایج گوگل شود.اعتماد بیش از حد به robots.txt برای جلوگیری از ایندکس

robots.txt فقط جلوی خزش را میگیرد، اما ایندکس شدن را تضمین نمیکند. ممکن است صفحهای که بلاک شده از طریق بکلینکها در نتایج ظاهر شود. برای جلوگیری قطعی باید از meta robots با مقدارnoindexاستفاده کنید.مسدود کردن منابع حیاتی

بلاک کردن فایلهای CSS یا JS باعث میشود گوگل نتواند نسخه واقعی سایت را ببیند. نتیجه این کار، افت تجربه کاربری و در نهایت کاهش رتبهبندی است.عدم بهروزرسانی فایل

ساختار سایت تغییر میکند اما فایل robots.txt قدیمی باقی میماند. نتیجه؟ موتورهای جستجو مسیرهای اشتباهی را دنبال میکنند و صفحات ارزشمند از دسترس خارج میشوند.استفاده نادرست از نمادها

نمادهایی مثل*یا$اگر بهطور نادرست استفاده شوند، میتوانند بیشتر از حد نیاز صفحات را مسدود کنند. برای مثال:

این دستور همه صفحات php را بلاک میکند، حتی اگر برخی از آنها ارزشمند باشند. این یک اشتباه رایج بین تازهکارهاست.

اشتباهات رایج در robots.txt

| اشتباه رایج | پیامد منفی | راهحل |

|---|---|---|

| Disallow: / | مسدود شدن کل سایت از ایندکس | حذف یا اصلاح دستور |

| اتکا به robots.txt برای noindex | احتمال ایندکس شدن صفحات بلاکشده | استفاده از meta robots |

| بلاک کردن CSS یا JS | درک ناقص موتور جستجو از ظاهر سایت | اجازه دسترسی کامل |

| عدم بهروزرسانی فایل | مسدود شدن یا باز شدن مسیرهای اشتباه | بازبینی و تست منظم |

| استفاده نادرست از * یا $ | مسدود شدن بیش از حد یا اشتباه صفحات | تست با ابزارهای معتبر |

بهطور خلاصه، فایل robots.txt اگر با دقت و دانش کافی نوشته شود، ابزاری قدرتمند برای بهبود سئو است. اما اگر بیاحتیاطی کنید، میتواند کل استراتژی شما را از مسیر خارج کند. با رعایت این بایدها و اجتناب از نبایدها، میتوانید مطمئن شوید موتورهای جستجو درست همان صفحاتی را میبینند که برای کسبوکار شما اهمیت دارند.

سوالات متداول درباره فایل robots txt

1.robots.txt چیست و چه نقشی در سئو دارد؟

robots.txt یک فایل متنی ساده است که در ریشه سایت قرار میگیرد و وظیفه اصلی آن هدایت خزندههای موتورهای جستجو است. این فایل به رباتها دستور میدهد که کدام بخشهای سایت را بررسی کنند و کدام بخشها را نادیده بگیرند (خزش نکنند). نقش حیاتی آن در سئو، مدیریت بودجه خزش (Crawl Budget) است. با جلوگیری از خزش صفحات غیرضروری (مثل پوشههای مدیریتی یا تکراری)، تمرکز رباتها روی محتوای ارزشمندتر سایت افزایش مییابد و در نتیجه، سرعت و کیفیت ایندکس بهبود مییابد.

2.تفاوت اصلی robots.txt با Meta Robots Tag چیست؟

این دو ابزار مکمل یکدیگرند اما در سطوح متفاوتی عمل میکنند. robots.txt در سطح کلی (پوشهها و مسیرها) عمل کرده و صرفاً اجازه ورود میدهد یا مانع خزش میشود. در مقابل، Meta Robots Tag در سطح جزئی (یک صفحه خاص) عمل میکند و مستقیماً با دستوراتی مثل noindex یا nofollow، کنترل میکند که آیا یک صفحه ایندکس شود یا خیر. نکته مهم اینجاست که robots.txt فقط جلوی خزش را میگیرد؛ بنابراین برای جلوگیری قطعی از ایندکس شدن یک صفحه، حتماً باید از meta robots noindex استفاده کرد.

3.اجزای اصلی ساختار robots.txt کدامند و کارشان چیست؟

چهار دستور کلیدی در ساختار robots.txt وجود دارند: User-agent که ربات هدف را تعیین میکند (مثلاً Googlebot یا همه رباتها با *)؛ Disallow که ممنوعیت خزش یک مسیر یا پوشه را مشخص میکند؛ Allow که اجازه خزش یک مسیر خاص را در دل یک پوشه ممنوع صادر میکند؛ و در نهایت Sitemap که آدرس کامل نقشه سایت (XML Sitemap) را به موتورهای جستجو معرفی میکند. دستورات باید شفاف، دقیق و هدفمند نوشته شوند.

4.چه زمانی نیاز به استفاده و مدیریت robots.txt داریم؟

استفاده از این فایل ضروری است، زمانی که بخواهید از ایندکس شدن صفحات غیرضروری (مانند صفحات تستی، لاگها یا بخشهای مدیریتی) جلوگیری کرده و بودجه خزش را بهینه کنید. مدیریت صحیح این فایل بهویژه برای سایتهای بزرگ یا فروشگاههای اینترنتی با صفحات زیاد، که هدررفت بودجه خزش در آنها رایج است، حیاتی محسوب میشود.

5.مهمترین اشتباهاتی که باید در robots.txt از آنها دوری کرد، کدامند؟

باید از سه اشتباه رایج دوری کنید. اول، بلاک کردن کل سایت با استفاده ناخواسته از دستور Disallow: / که باعث حذف کامل سایت از نتایج گوگل میشود. دوم، مسدود کردن منابع حیاتی مانند فایلهای CSS یا JavaScript؛ زیرا گوگل برای درک درست ظاهر و عملکرد سایت به این فایلها نیاز دارد. و سوم، تکیه صرف بر robots.txt برای noindex؛ چون این فایل جلوی ایندکس شدن را تضمین نمیکند و برای حذف قطعی یک صفحه از نتایج، باید از متا تگ noindex استفاده شود.

6.بهترین روش (Best Practice) برای تنظیم این فایل چیست؟

همیشه فایل را در ریشه (Root) وبسایت قرار دهید. حتماً آدرس کامل نقشه سایت (Sitemap) را در انتهای فایل معرفی کنید تا خزندهها بهینه و هوشمندانهتر عمل کنند. در نهایت، پس از هر تغییر، فایل را با ابزار تست robots.txt گوگل سرچ کنسول تست و اعتبارسنجی کنید تا مطمئن شوید هیچ صفحه مهمی به اشتباه بلاک نشده است. فایل robots.txt چیزی فراتر از یک سند متنی ساده است؛ این فایل در واقع راهنمای قدرتمند ترافیک سایت شماست. همانطور که دیدیم، مدیریت دقیق آن نه تنها از هدر رفتن بودجه خزش (Crawl Budget) جلوگیری میکند، بلکه مطمئن میشود که الماسهای ارزشمند سایت شما (یعنی صفحات کلیدی)، سریعتر و بهتر در رادارهای گوگل ثبت شوند. سئوی تکنیکال موفق، با همین مدیریت هوشمندانه و توجه به جزئیات آغاز میشود. شما با تسلط بر ساختار و پرهیز از خطاهای فاجعهآور (مثل بلاک کردن CSS/JS)، کنترل کامل سرنوشت ایندکس شدن سایتتان را به دست میگیرید.

اگر آمادهاید تا دانش کسبشده را در ساختار فنی سایت خود پیاده کنید یا میخواهید از یک متخصص برای بهینهسازی بینقص بودجه خزش کمک بگیرید، ما دقیقاً همان جایی هستیم که باید باشید. ما در nemove.ir مشتاقانه منتظر شما هستیم:

- عمیقتر شوید و حرفهایتر عمل کنید: اگر اشتیاق دارید تا جزئیات سئوی تکنیکال را بیشتر کاوش کنید، همین حالا به بخش بلاگهای تخصصی سئو و فنی ما در وبسایت سر بزنید. ما منابعی را فراهم کردهایم که به شما کمک میکند همیشه یک گام جلوتر از رقبا باشید.

- سئو را بدون خطا پیش ببرید: اگر در تست robots.txt یا پیادهسازی استراتژیهای پیچیده سئو نیاز به راهنمایی دارید، با مراجعه به صفحه تماس با ما میتوانید مشاورهای تخصصی دریافت کنید. ما به شما کمک میکنیم که مطمئن شوید هر دستور در فایل robots.txt در جهت رشد شما کار میکند.

«فایل robots.txt یک سند متنی ساده در ریشه سایت است که به موتورهای جستجو میگوید کدام بخشها را بخزند و کدام بخشها را نادیده بگیرند. این فایل ابزاری کلیدی برای مدیریت بودجه خزش و بهینهسازی سئو محسوب میشود.»

keyvan ghouroghi

تاریخ: 1404/09/05من این مقاله رو به همکارام هم معرفی کردم چون فکر میکنم برای خیلیها میتونه مسیر رو روشنتر کنه. ممنون که محتوای باکیفیت تولید میکنید.